在配置之前,先详细了解一下ONTAP 的一些概念,如果概念了解不清楚,看着教程一路下一步,到最后,还是云里雾里的。通了就跑,不会长久。ONTAP Select 功能和DM非常相似,学会了Select 的配置,联想的DM存储一般配置使用就没问题。

本章节总共有两部分内容:概念、配置

一,概念

聚合

聚合是节点管理的磁盘的容器。可使用聚合隔离性能需求不同的工作负载,为存取模式不同的数据分层,或出于法规原因隔离数据。

• 对于要求延迟尽量低,性能尽量高的业务关键型应用程序,可以创建完全由固态硬盘构成的聚合。

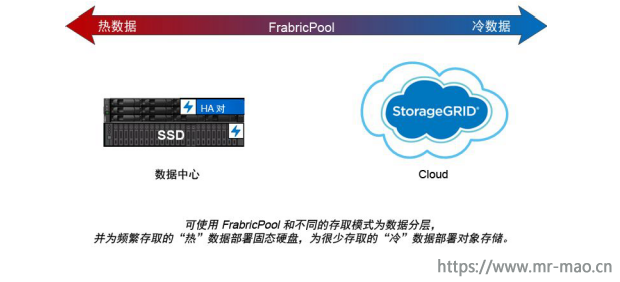

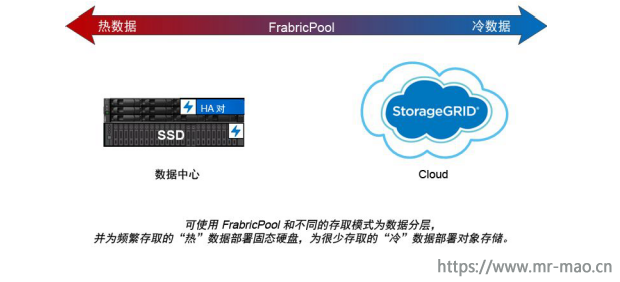

• 要为存取模式不同的数据分层,可创建混合聚合,从而将闪存部署为工作数据集的高性能高速缓存,同时使用成本较低的硬盘或对象存储来存储访问频率较低的数据。FlashPool由固态硬盘和硬盘构成。FabricPool有全固态硬盘聚合和连接的对象存储构成。

• 如果因为法规原因需要将归档数据与活动数据隔离,可使用由容量硬盘构成的聚合,或性能硬盘和容量硬盘的组合。

聚合和 RAID 组

现代 RAID 技术通过在备用磁盘上重建故障磁盘的数据来抵御磁盘故障。系统将“奇偶校验磁盘”上的索引信息与其余正常磁盘上的数据进行比较,以便重建缺少的数据,而整个过程中都不会停机或造成大量性能成本。

聚合由一个或多个RAID 组构成。聚合的RAID 类型决定 RAID 组中的奇偶校验磁盘数量和 RAID配置可同时抵御的磁盘故障数量。

缺省 RAID 类型 RAID-DP(RAID 双重奇偶校验)要求每个 RAID 组中包含两个奇偶校验磁盘,并且可以在两个磁盘同时发生故障时防止数据丢失。对于 RAID-DP,建议 RAID 组大小为 12 到20 个硬盘和 20 到 28 个固态硬盘。可通过以更高端的大小建议创建 RAID 组来分摊奇偶校验磁盘的间接成本。这尤其适合固态硬盘,因为固态硬盘的可靠性比容量驱动器的高得多。对于硬盘聚合,应平衡最大化磁盘存储需求与抵消因素(如更大 RAID 组需要的重建时间更多)

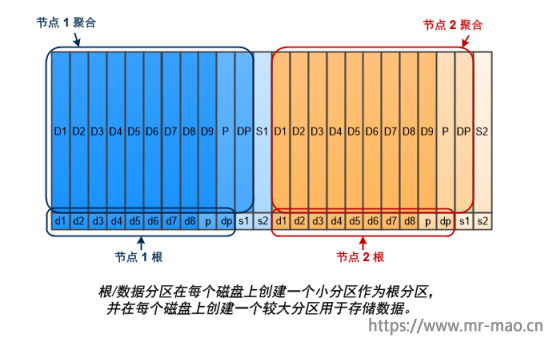

根/数据分区

每个节点都必须有一个根聚合来存储存储系统配置文件。根聚合具有 RAID 类型的数据聚合。

类型为 RAID-DP 的根聚合通常由一个数据磁盘和两个奇偶校验磁盘构成。这是当系统已经为聚合中的每个 RAID 组保留了两个磁盘来充当时,存储系统文件需要支付的重要“奇偶校验代价”。

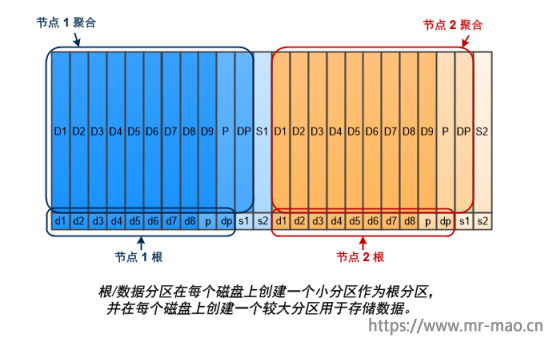

根数据分区通过让磁盘分区分摊根聚合,在每个磁盘上保留一个较小分区充当根分配,并为数据保留一个较大分区,降低奇偶校验代价。

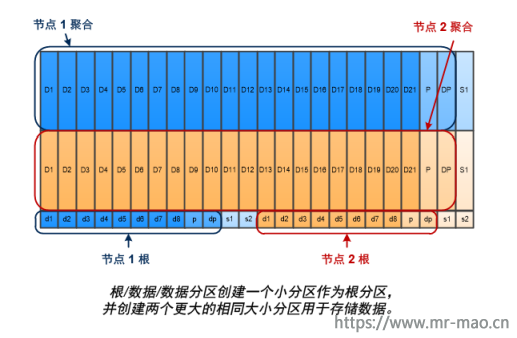

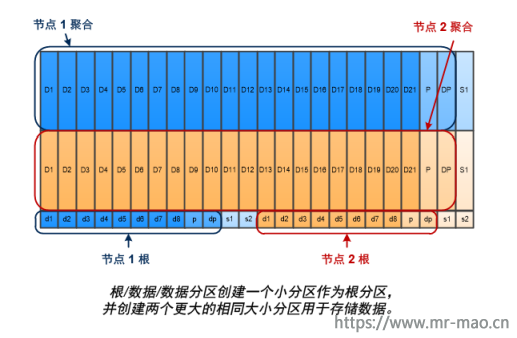

如图所示,用于存储根聚合的磁盘越多,根分区越小。这一条对称为根-数据-数据-分区的根数据分区格式也成立,这会创建一个较小分区充当根分区,两个大小相同的较大分区用于存储数据。

这两种根-数据分区属于 ONTAP高级驱动器分区(ADP)功能的一部分。两者均在出厂时配置:根-数据分区适用于入门级 DM7000H 和全闪存阵列相同,而根-数据-数据分区则仅适用于全闪存阵列系统。

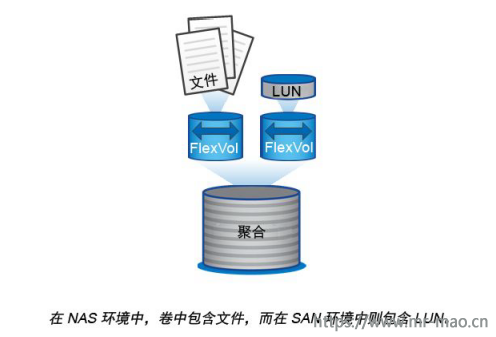

卷、Qtree、文件和 LUN

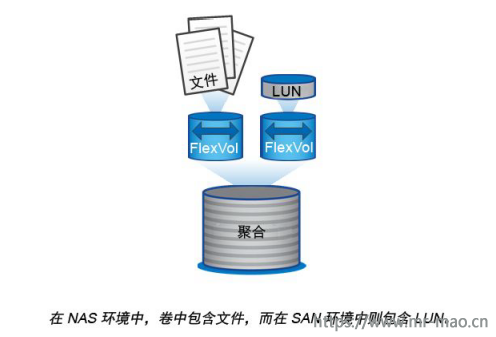

ONTAP 从称为FlexVol 卷的逻辑容器向客户端和主机提供数据。由于这些卷仅与其所属聚合松散耦合,所以在管理数据时比传统卷的灵活性更高。

可为一个聚合分配多个 FlexVol 卷,每个卷专用于一个不同的应用程序或服务。可扩展和缩小FlexVol 卷,移动 FlexVol 卷或创建 FlexVol 卷的占用空间较小的拷贝。可使用Qtree将一个FlexVol 卷拆分为多个可管理单元,可使用配额限制卷的资源使用量。

在 NAS 环境中,卷中包含文件系统,而在 SAN 环境中则包含 LUN。LUN(逻辑单元号)是按SAN 协议寻址的一种称为逻辑单元的设备的标识。

LUN 是 SAN 配置中的基本存储单元。Windows 主机将存储系统上的 LUN 视为虚拟磁盘。可根据需要将 LUN 无中断地移到其他卷。除了数据卷,还需要了解几种特殊卷:

• A节点根卷(通常为 “vol0 ”)中包含节点配置信息和日志。

• 将SVM 根卷充当 SVM 提供的命名空间的入口点,其中包含命名空间目录信息。

• 系统卷中包含特殊元数据,如服务审核日志。

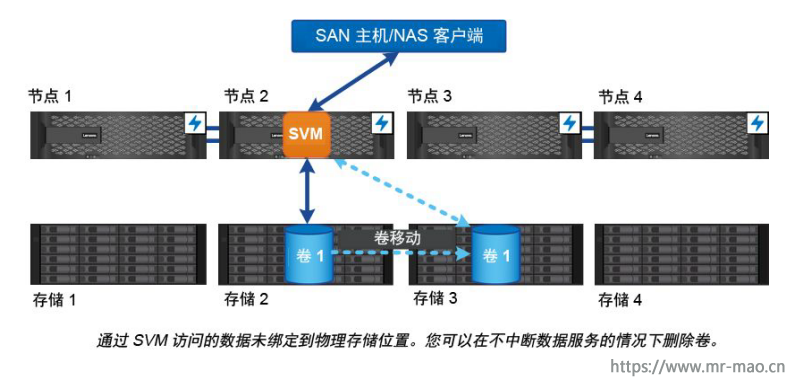

SVM

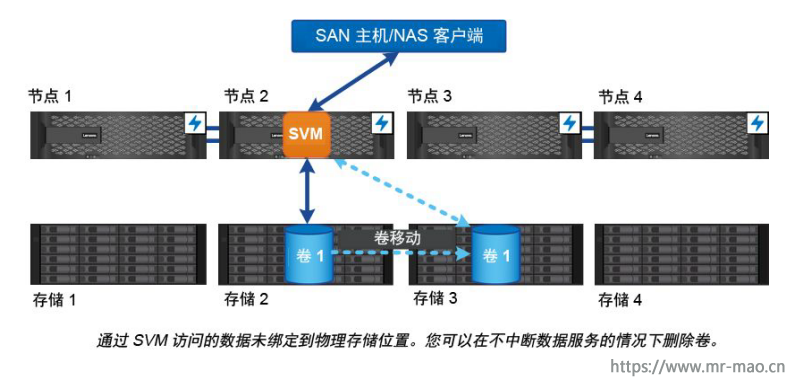

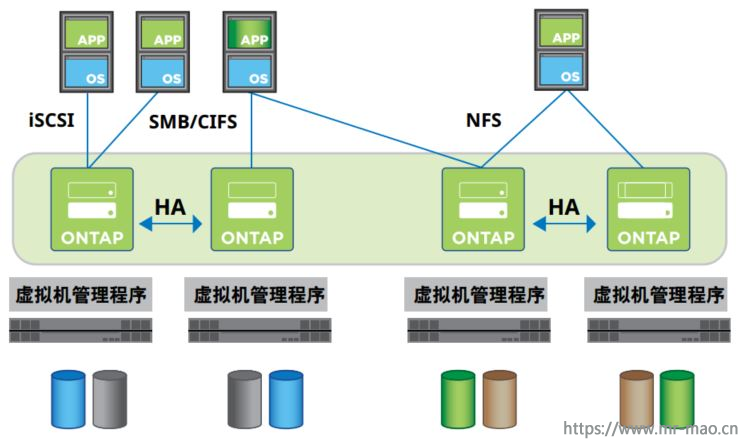

存储虚拟机(SVM)为客户端和主机提供数据。与虚拟机监控程序上运行的虚拟机一样,SVM 是抽取物理资源的逻辑实体。通过 SVM 访问的数据不绑定到存储中的位置。SVM 的网络访问不绑定到物理端口。

注: SVM 以前称为 “vserver”。您将在 ONTAP 命令行界面(CLI)中看到此术语。

SVM 通过一个或多个网络逻辑接口(LIF)从一个或多个卷向客户端和主机提供数据。可将卷分配给集群中的任何数据聚合。可通过任何物理端口或逻辑端口托管 LIF。无论在执行硬件升级,t添加节点、均衡性能还是优化聚合之间的容量,都可以在不中断数据服务的情况下移动卷和 LIF。同一个 SVM 可以有用于 NAS 流量的 LIF 和用于 SAN 流量的 LIF。客户端和主机只需要 LIF 的地址(NFS、SMB 或 iSCSI 需要 IP 地址,FC 需要 WWPN)即可访问 SVM。LIF 在移动时保持其地址。端口可托管多个 LIF。每个 SVM 都有自己的安全设置、管理方法和命名空间。

除了数据 SVM,ONTAP 还部署特殊 SVM 来进行管理:

• 将 设置集群时将创建管理SVM。

• A 节点加入新集群或现有集群时创建节点SVM。

• A 系统会在 IPspace 中自动创建系统 SVM以实现集群级通信。

不能使用这些 SVM 提供数据。还有一些特殊 LIF 用于集群内部和之间的流量,以及用于集群和节点管理。

高可用HA

高可用性(HA)对中配置的集群节点针对容错和无中断操作。如果一个节点发生故障,或者您需要关闭节点以进行例行维护,则可由其伙伴接管其存储并继续从中提供数据。节点恢复联机之后,伙伴交还存储。

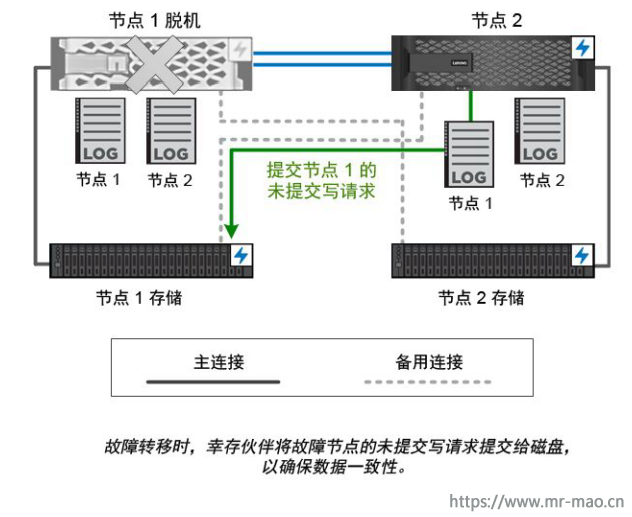

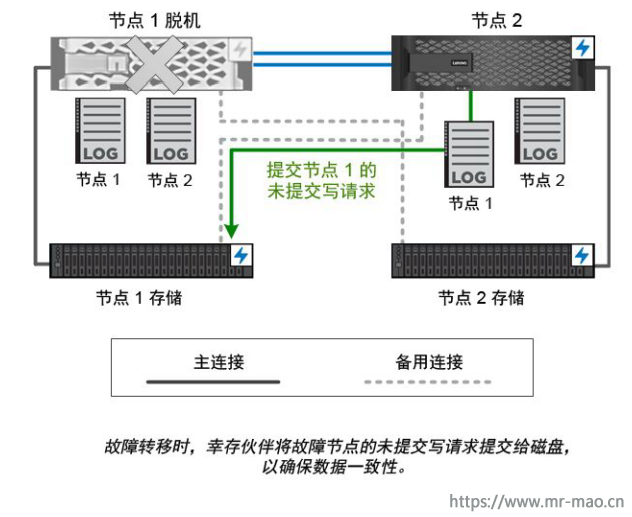

HA 对始终由相似控制器型号构成。这些控制器通常位于配有冗余电源模块的同一个机箱中。内部 HA 互连让每个节点可以持续检查其伙伴是否正在运行,以及镜像对方的非易失性内存的日志数据。创建针对节点的写请求时,将响应发送回客户端或主机之前,该请求将同时记录到两个节点的 NVRAM 中。故障转移时,幸存伙伴将故障节点的未提交写请求提交给磁盘,以确保数据一致性。

与另一个控制器的存储介质之间的连接让每个节点可以在接管时访问对方的存储。网络路径故障转移机制确保客户端和主机可以与幸存节点通信。要确保可用性,每个节点上的性能容量利用率应保持在 50%,以在故障转移时处理额外的工作负载。同样的原因,可能需要为节点配置不超过 50% 的最大 NAS 虚拟网络接口数量。

在 ONTAP Cloud 或 ONTAP Select 这样的虚拟化“无共享” ONTAP,实施中,节点之间不共享存储。在节点发生故障时,其伙伴将继续从该节点的同步镜像数据拷贝提供数据。不会接管节点的存储,仅接管其数据提供功能。

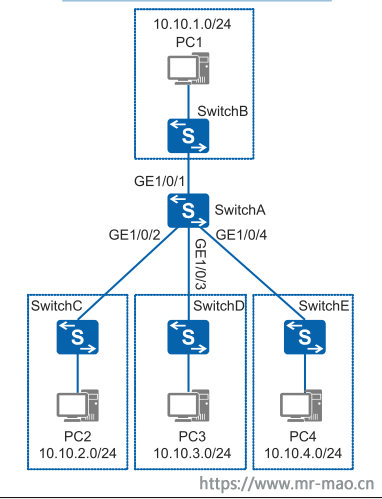

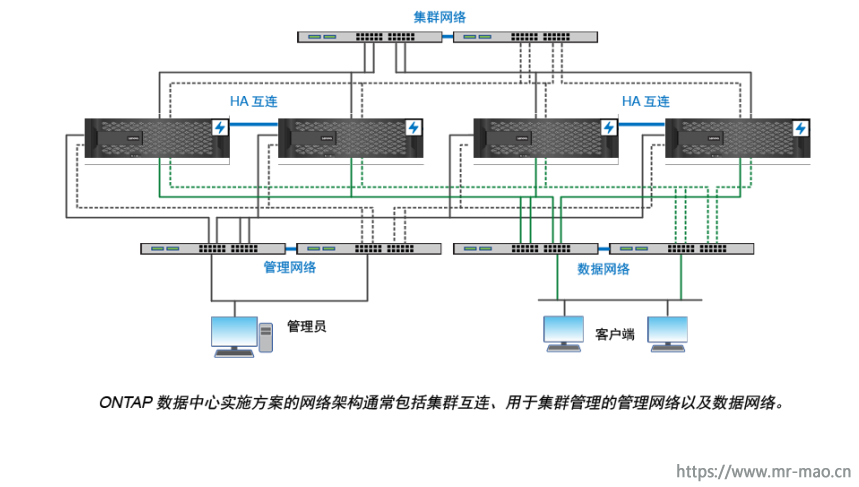

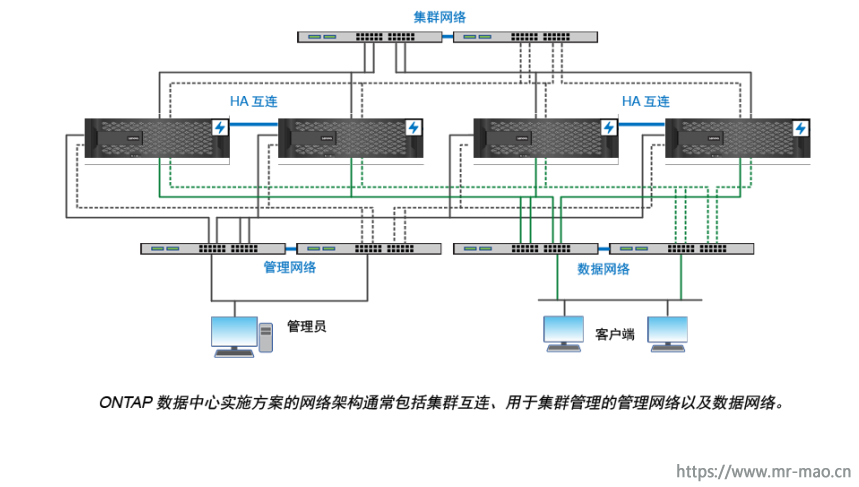

网络

ONTAP 数据中心实施方案的网络架构通常包括集群互连、用于集群管理的管理网络以及数据网络。NIC(网络接口卡)为以太网连接提供物理端口。HBA(主机总线适配器)为 FC 连接提供物理端口

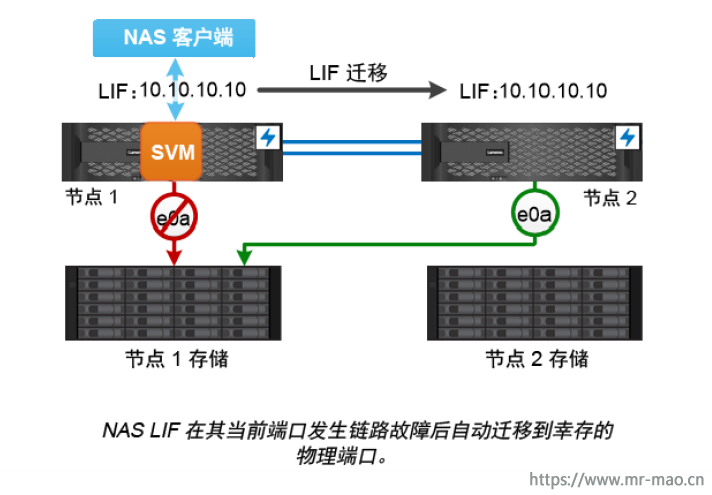

路径故障转移

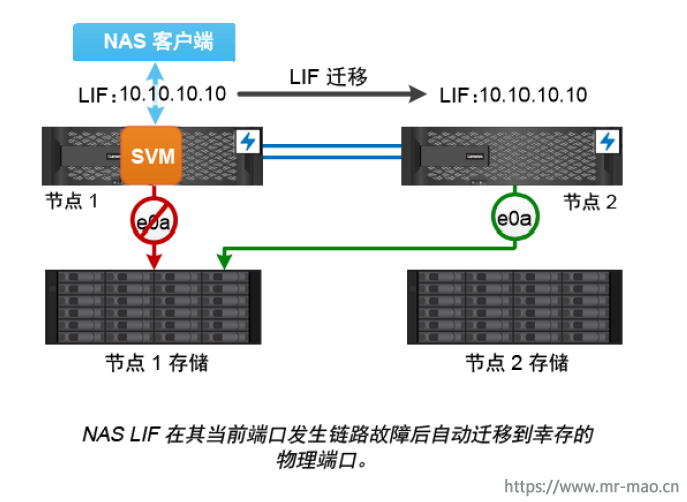

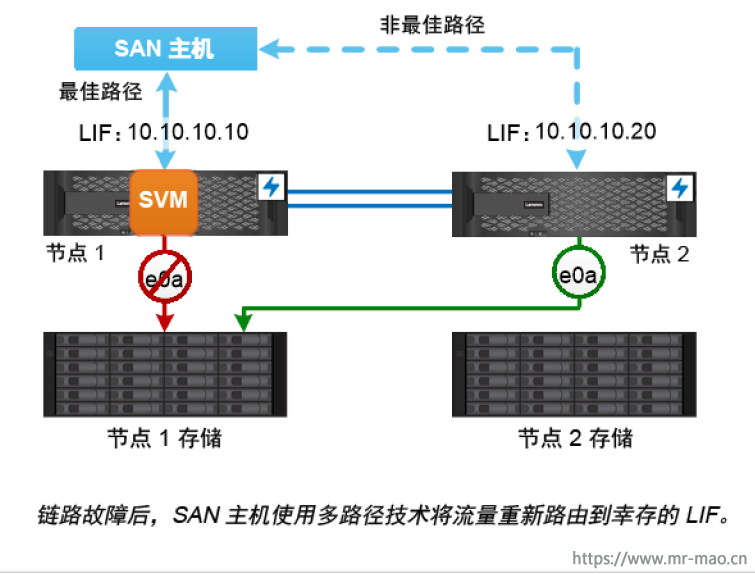

ONTAP 管理 NAS 和 SAN 拓扑中的路径故障转移的方式存在重大差别。NAS LIF 在链路故障转移后自动迁移到另一个物理端口。SAN LIF 不迁移(除非您在发生故障后手动移动)。实际上,主机采用的多路径技术将流量转移到同一个 SVM 上的另一个 LIF,但是访问其他网络端口。

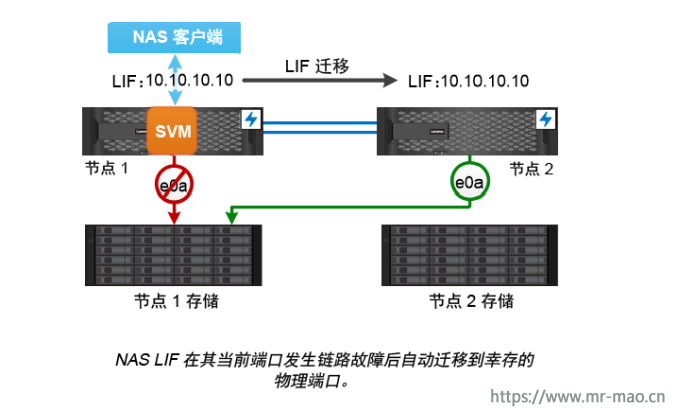

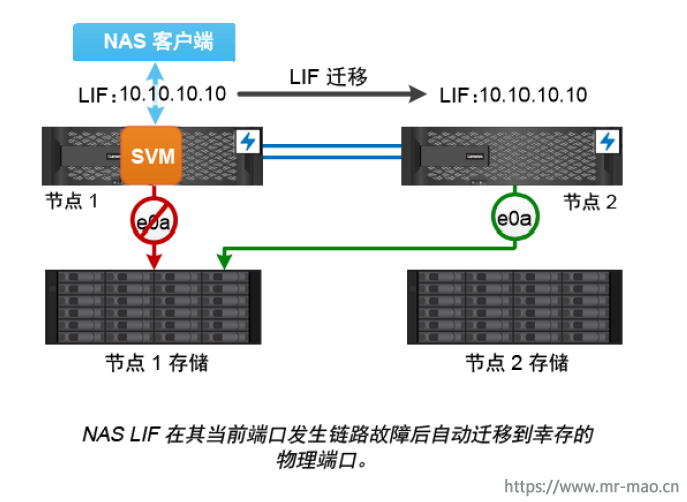

NAS路径故障转移

NAS LIF 在其当前端口发生链路故障后自动迁移到幸存的物理端口。LIF 要迁移到的端口必须是LIF 的故障转移组的成员。故障转移组策略将数据 LIF 的故障转移目标缩小到拥有数据及其 HA伙伴的节点上的端口。

为了管理方便起见,ONTAP 为网络体系结构中的每个广播域创建一个故障转移组。广播域为属于同一个第二层网络的端口分组。例如,如果在使用 VLAN 按部门(Engineering、Marketing、Finance 等)隔离流量,每个 VLAN 定义一个单独的广播域。只要添加或删除广播域端口,都将自动更新与广播域关联的故障转移组。

最好始终使用广播域来定义故障转移组,以确保故障转移组保持最新。但是,有时您可能希望定义不与广播域关联的故障转移组。例如,您可能希望 LIF 仅故障转移到广播域中定义的一小端口中的端口。

子网保留广播域中的一段 IP 地址。这些地址属于同一个第三层网络,并在创建 LIF 时分配给广播域中的端口。相比指定 IP地址和网络掩码,在定义 LIF 时指定子网名称通常更轻松,更不容易出错。

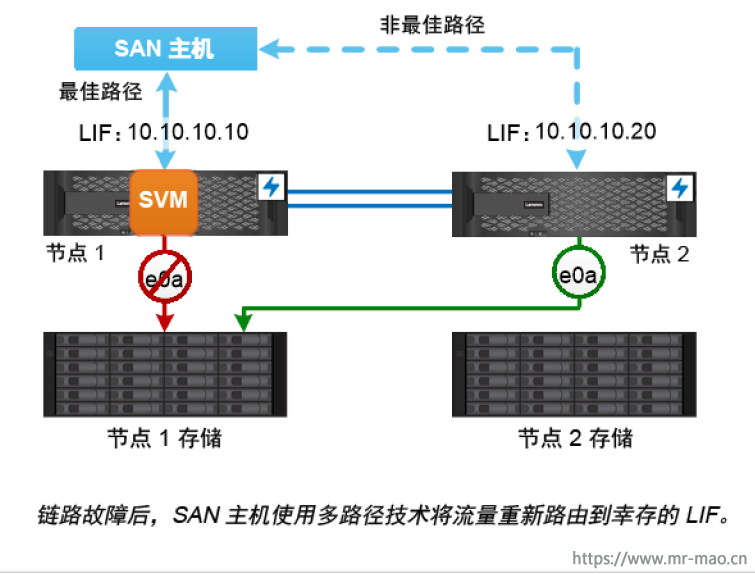

SAN 路径故障转移

发生链路故障时,SAN 主机使用 ALUA(非对称逻辑单元访问)和 MPIO(多路径 I/O)将流量重新路由到幸存 LIF。预定义的路径确定 SVM 提供的 LUN 的可行路由。

在 SAN 环境中,主机被视为针对 LUN目标的请求的发起方。

MPIO 可以实现多条从发起方到目标的路径。ALUA 可以确定最短路径,称为最佳路径。

通常可以在 LUN 所属节点上为 LIF 配置多个最佳路径,在其 HA 伙伴上为 LIF 配置多个非最佳路径。如果所属节点上的一个端口发生故障,主机将把流量路由到幸存端口。如果所有端口都发生故障,主机将通过非最佳路径路由流量。

可使用 ONTAP DSM 技术定义负载均衡策略,以便确定如何在 LUN 的最佳路径之间分配流量。

缺省情况下,ONTAP 选择性 LUN 映射(SLM)限制从主机到 LUN 的路径数量。新建的 LUN 只能通过该 LUN 或其 HA 伙伴所属节点的路径访问。还可以通过在发起方的端口集中配置 LIF 来限制对 LUN 的访问。

在 SAN 环境中移动卷

缺省情况下,ONTAP选择性 LUN 映射(SLM)限制从 SAN 主机到 LUN 的路径数量。新建的LUN 只能通过该 LUN 或其 HA伙伴所属节点(即 LUN 的报告节点)的路径访问。

这意味着将卷移到另一个 HA 对中的节点时,需要将目标 HA 对的报告节点添加到 LUN映射。然后可以在 MPIO 设置中指定新路径。卷移动完毕后,可从映射中删除源 HA 对的报告节点。

以上就是本章节所做操作中需要了解的一些概念

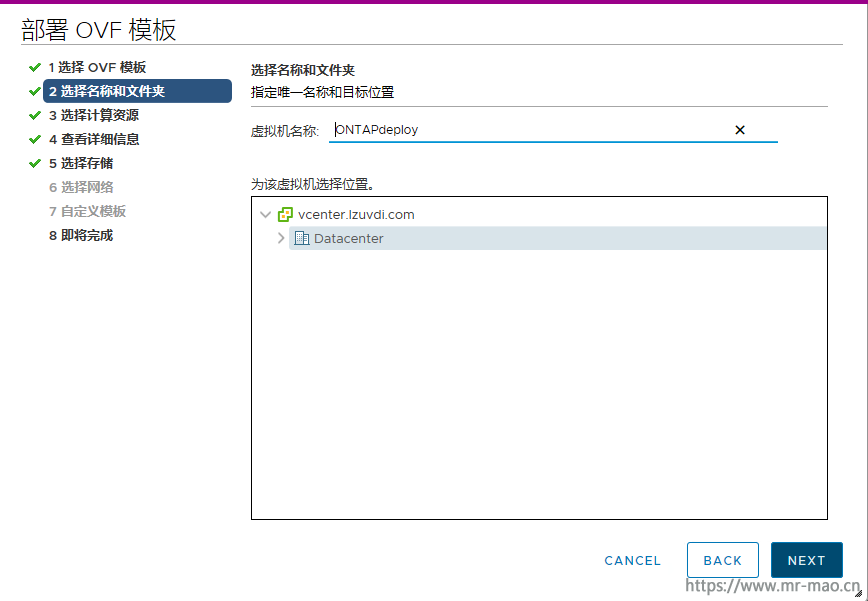

二,配置

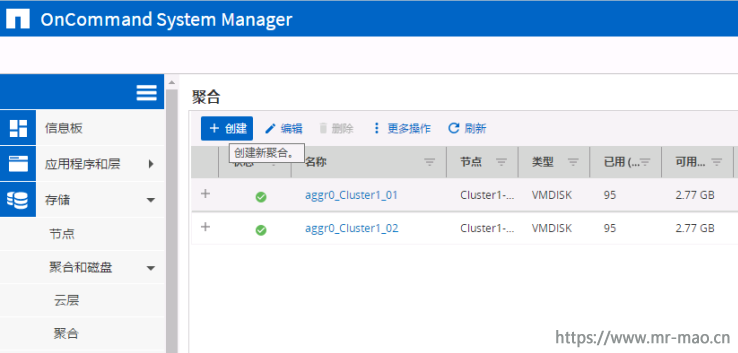

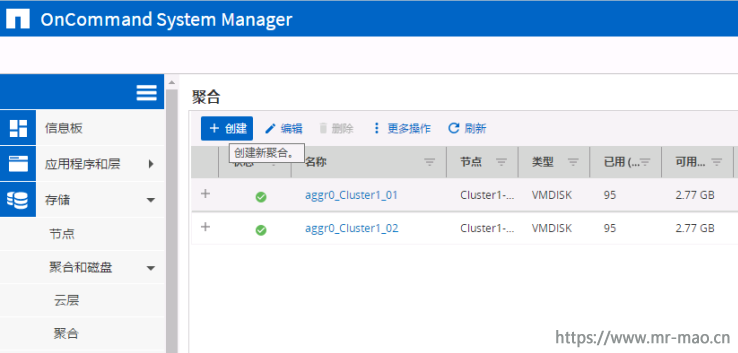

1,创建聚合

点击 存储--聚合和磁盘--聚合,然后单击创建

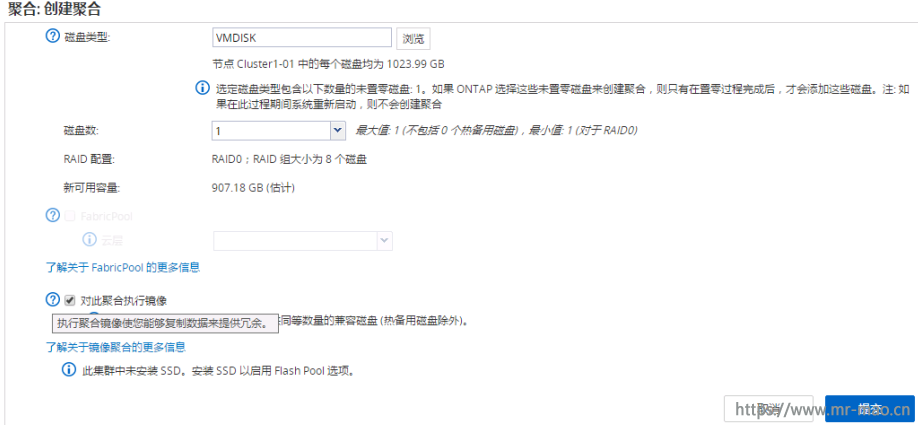

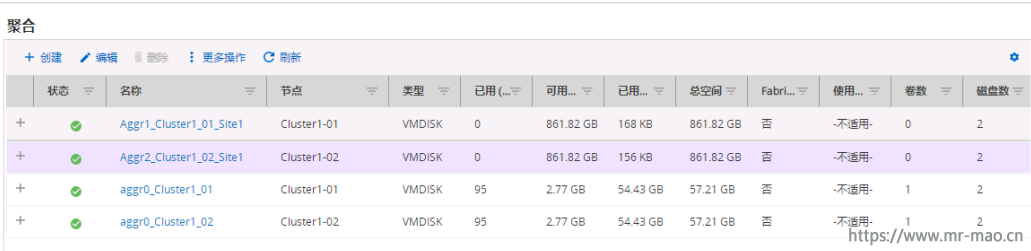

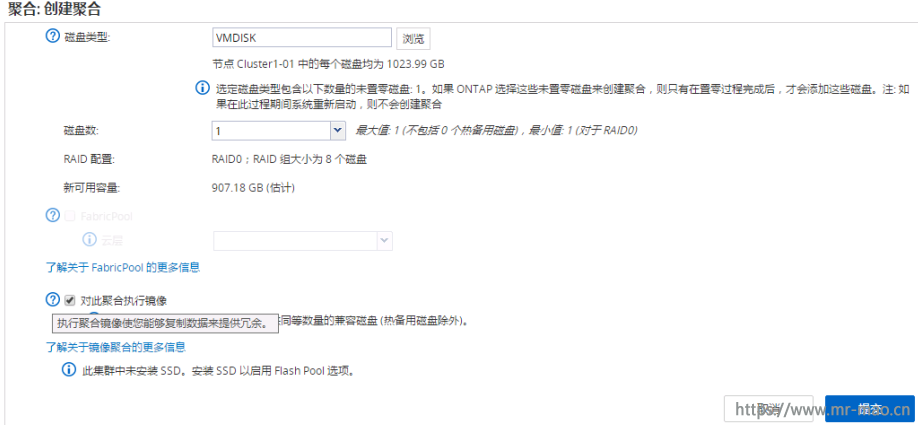

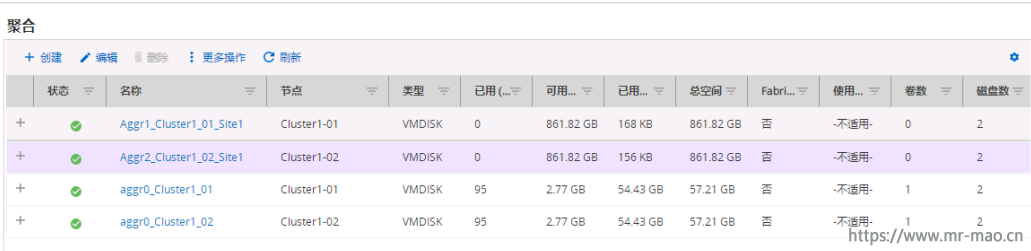

输入聚合名称,我这里输入的是Aggr1_Cluster1_01_Site1 和Aggr2_Cluster1_02_Site1

创建聚合的过程中,有一项"对此聚合执行镜像"默认勾选,关于这个功能的详细介绍,大家在创建过程中可以查看

Aggr1_Cluster1_01_Site1 代表:在站点1的第一个控制器的聚合

Aggr2_Cluster1_02_Site1 代表:在站点1的第二个控制器的聚合

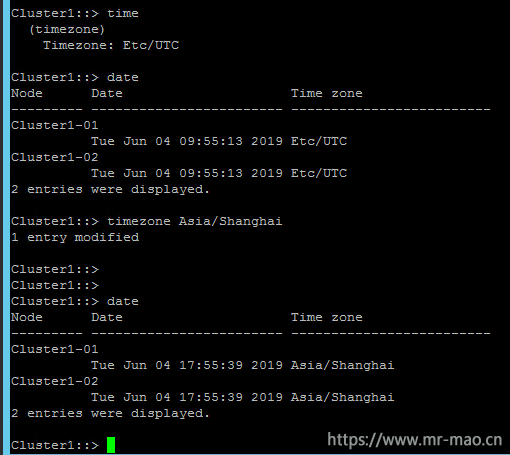

2,创建子网

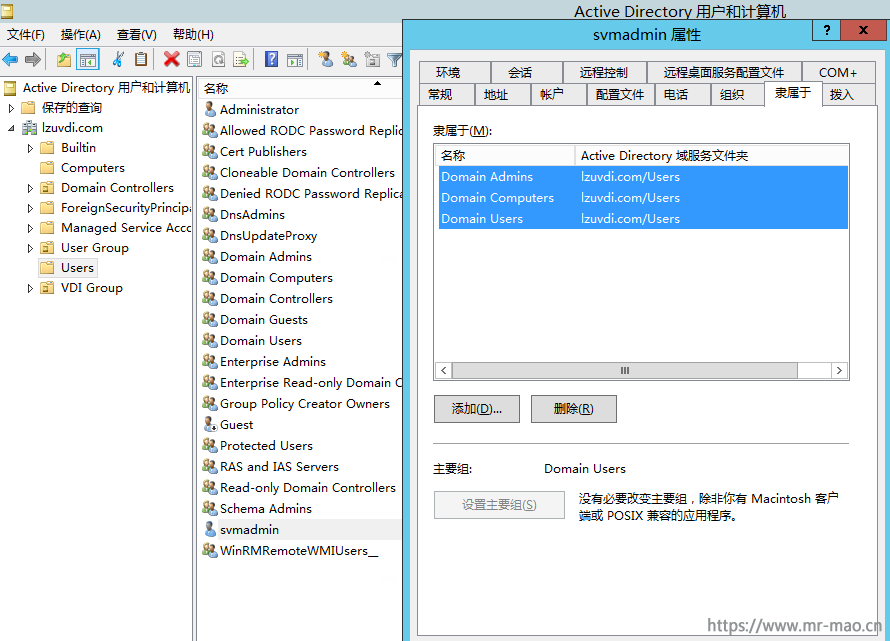

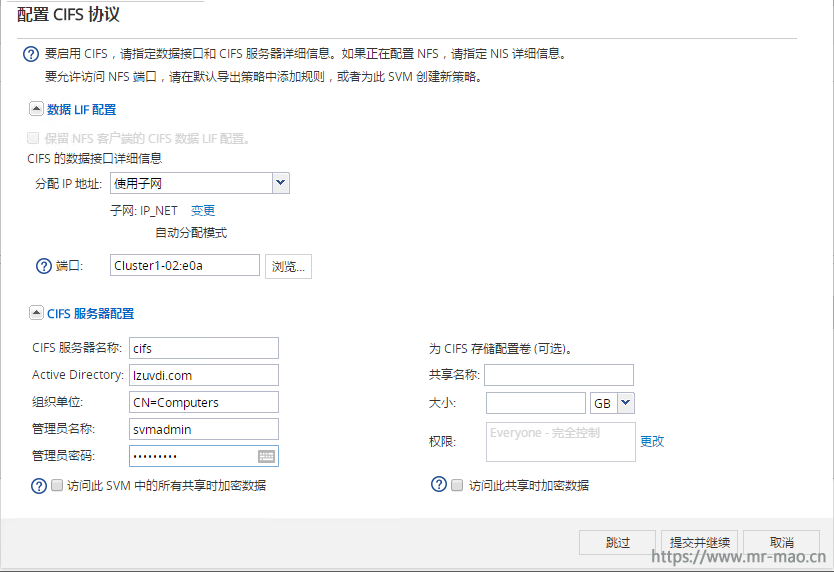

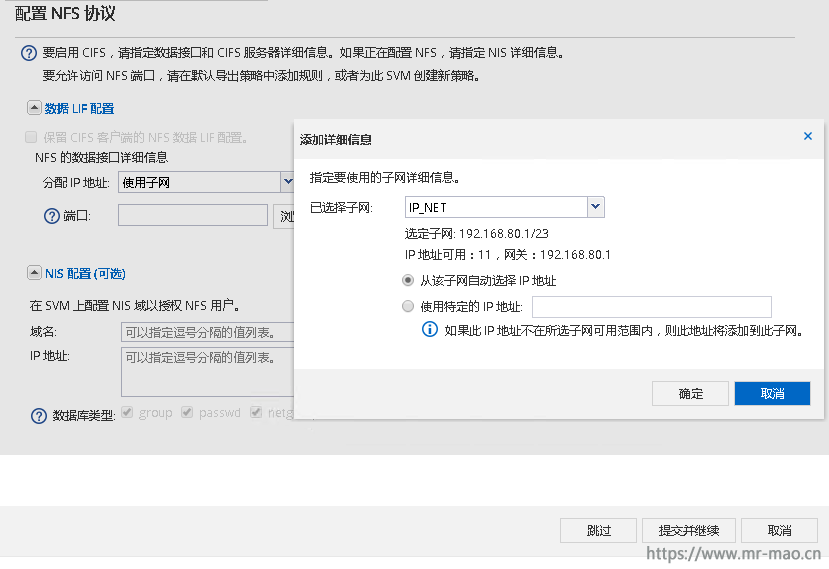

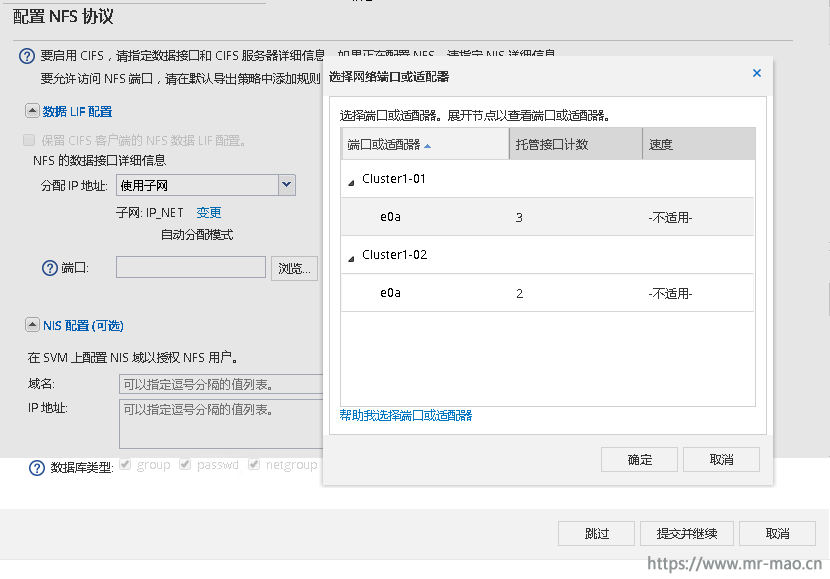

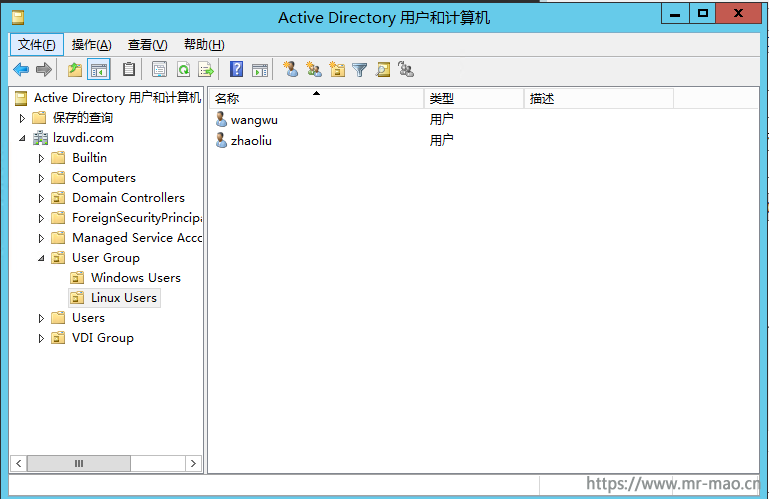

点击 网络--子网,单击创建,根据自己的环境填写信息,因为我的域控在管理网络,所以我选择了mgmt 的广播域,生产环境自行更改

3,创建SVM

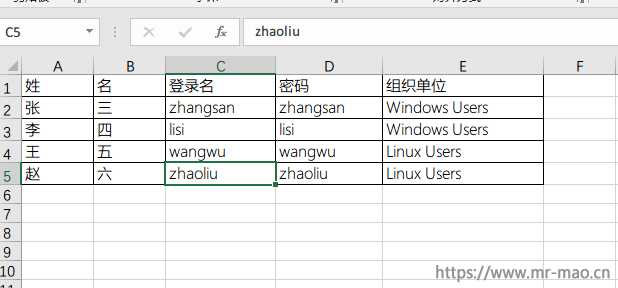

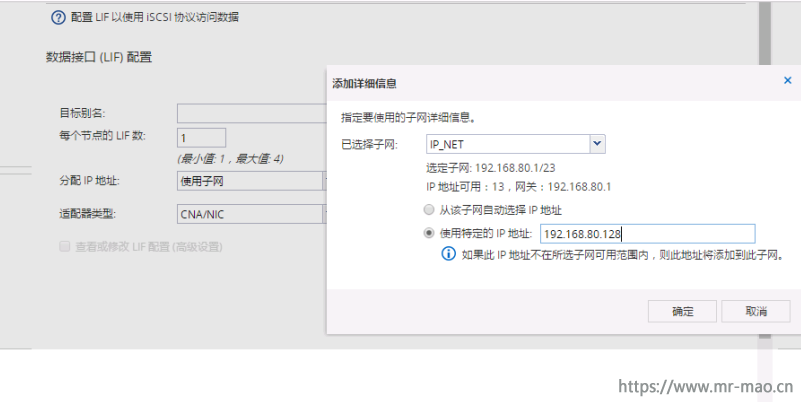

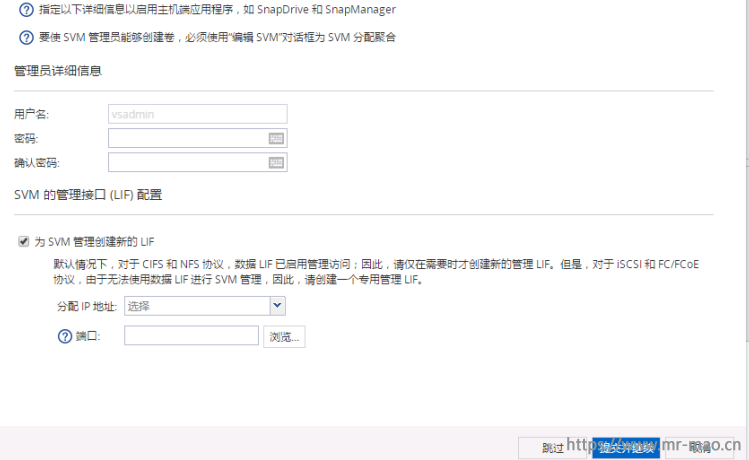

点击 存储--SVM,单击创建,数据协议勾选ISCSI,其它默认即可,单击提交并继续

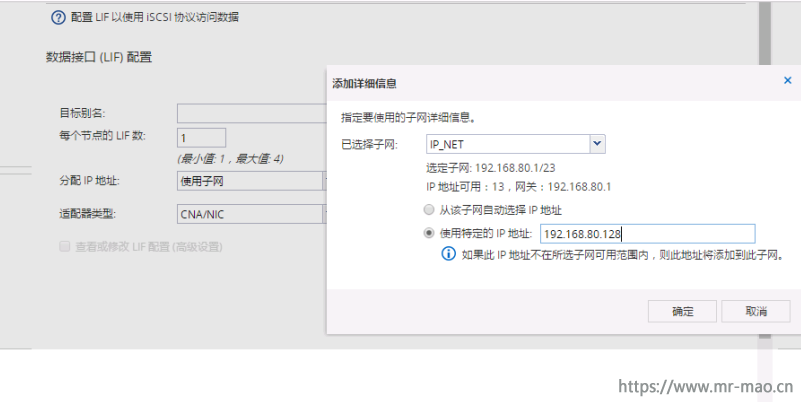

每个节点的逻辑接口数选择一个即可,这样,创建完SVM以后,会自动创建两个LIF 分布在两个控制器上,每个控制器一个,这样就实现了IP-SAN 的链路冗余,你也可以根据环境填多个接口数量。分配IP地址这里可以使用已经建立好的子网,也可以自己填。我这里填写192.168.80.128

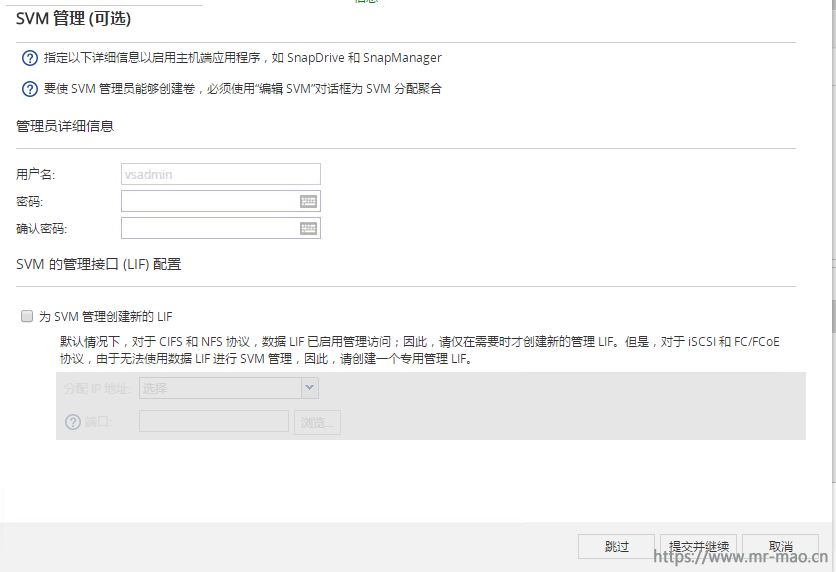

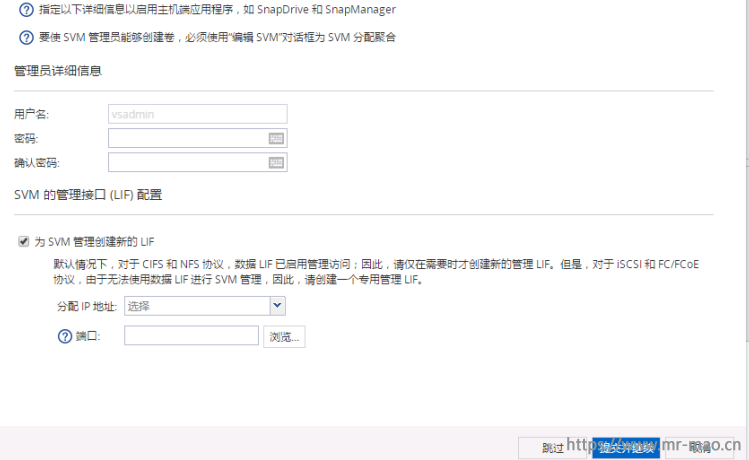

设置SVM管理,单击跳过即可

查看ISCSI服务状态,已经建立好了两个LIF接口,分布在两个控制器,一旦某个控制器发生故障,路径会自动转移到状态正常的控制器

4,创建ISCSI服务的端口集

单击 存储--LUN,在SVM下拉列表选择我们创建好的ISCSI_SVM,然后点击端口集,单击创建,填写名称,类型选择ISCSI,在选择 要与此端口集关联的接口 一栏里勾选两个ISCSI LIF 接口所在的端口,如下图所示,然后点击创建

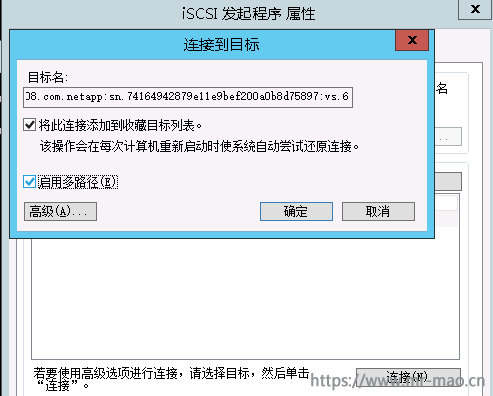

5,在主机端连接ISCSI目标设备,此处我以Windows演示,

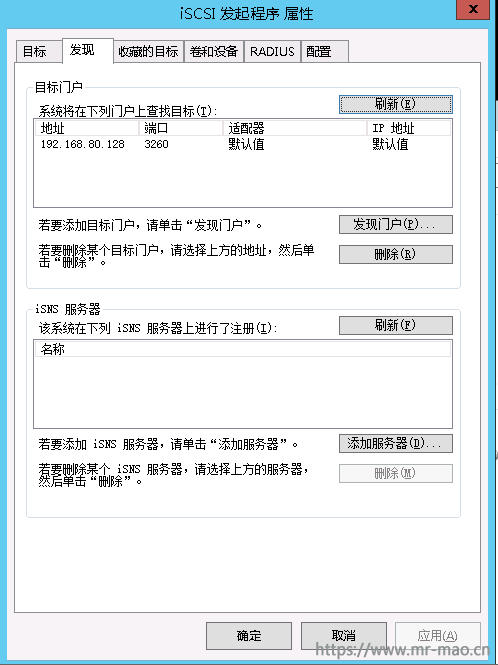

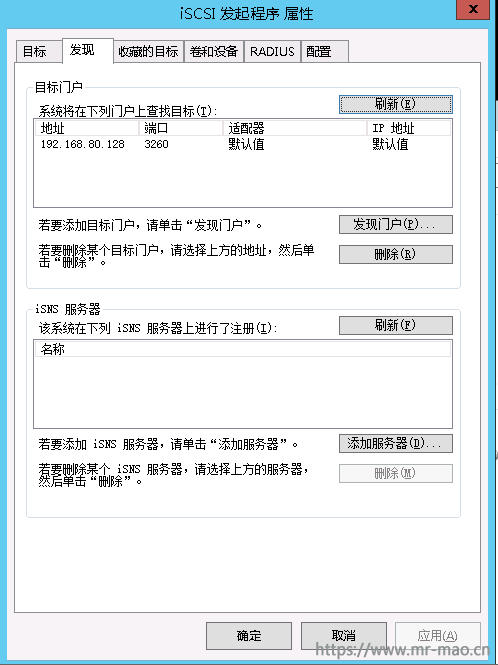

打开Windows的ISCSI发起程序,点击标签页的发现,单击发现门户,填写之前创建的第一个LIF IP 地址192.168.80.128

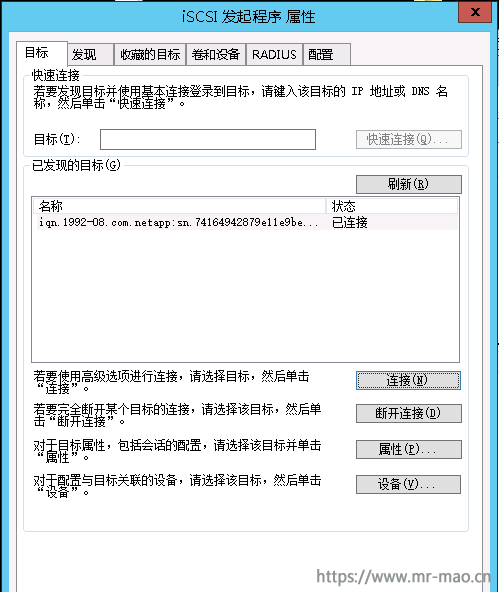

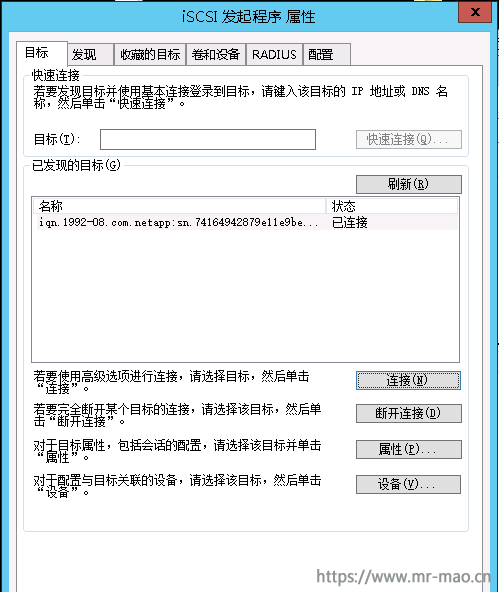

然后单击标签页的目标,选中名称为netapp 的目标,点击连接,状态为已连接则正常

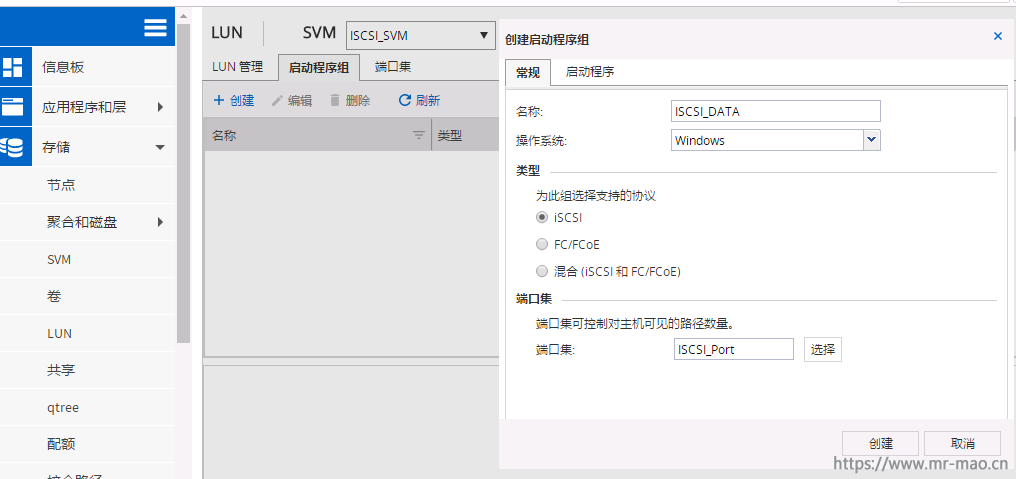

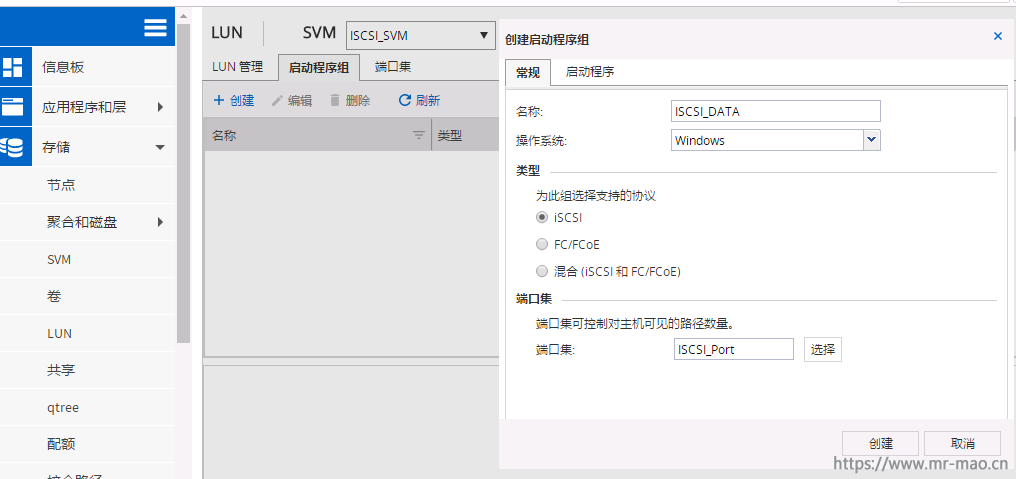

6,创建ISCSI服务的启动程序组

在 存储--LUN界面,单击启动程序组,单击创建,填写名称,操作系统为Windows,协议选择iscsi,端口集选择之前创建好的ISCSI_Port

然后单击启动程序,在选择启动程序列表选择我们第5步已连接的Windows启动程序,单击添加启动程序,如下图所示,单击创建

7,为ISCSI服务创建卷

点击 存储--卷,在SVM下拉列表选择之前创建的ISCSI_SVM,单击创建,选择FlexVol卷,填写名称,选择聚合,类型默认为iscsi,然后输入需要的容量大小,

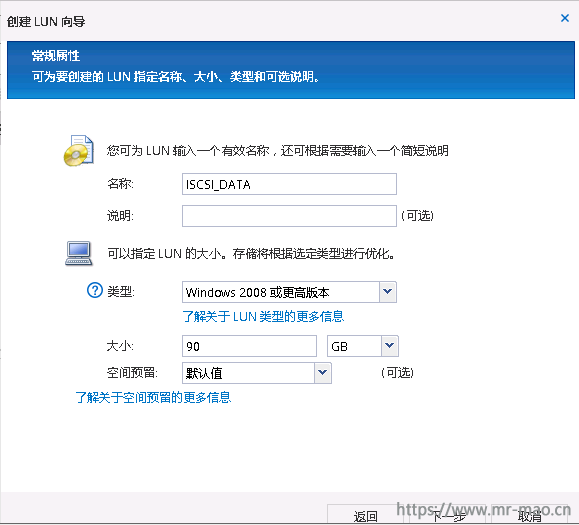

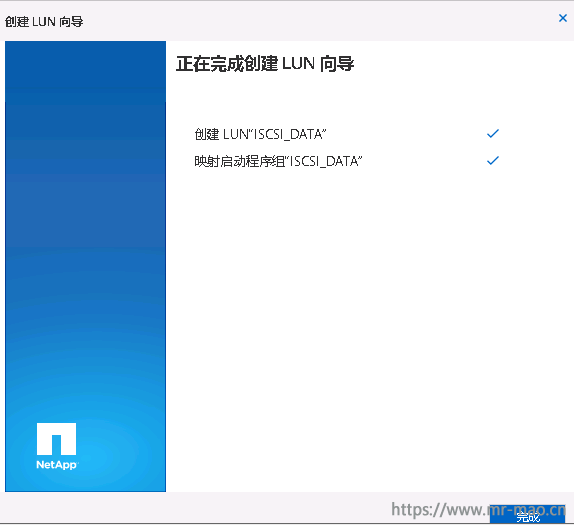

8,创建ISCSI LUN

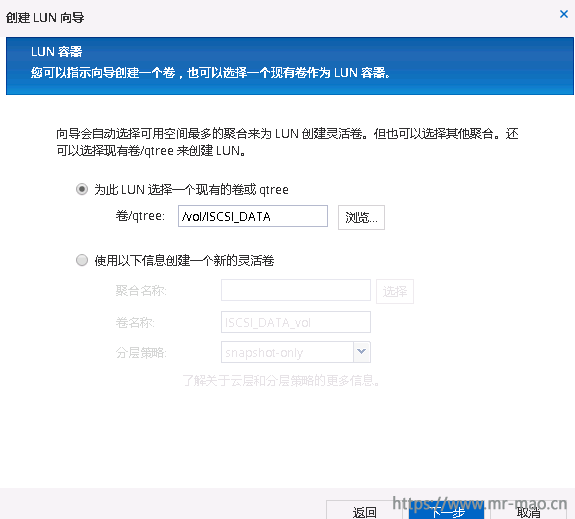

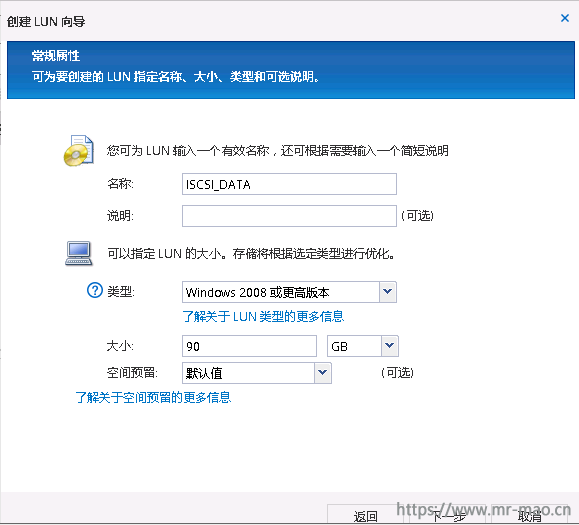

点击 存储--LUN,SVM下拉列表选择ISCSI_SVM,点击 LUN管理,单击创建,填写名称,容量大小,必须小于第7步创建的卷的总大小,我创建了100g的卷,在这里我填写90g,

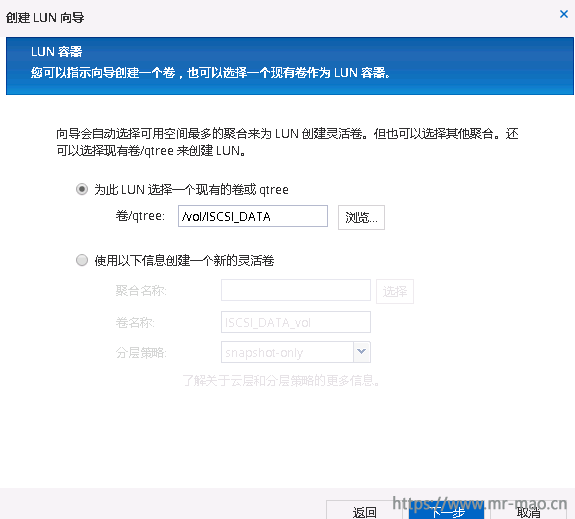

单击下一步,点击浏览,选择第7步创建好的卷

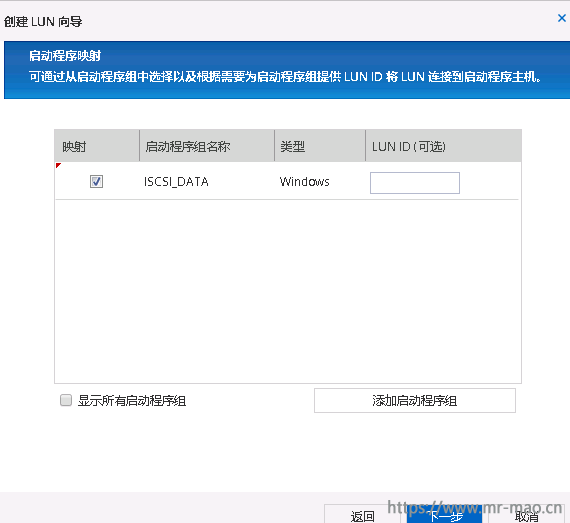

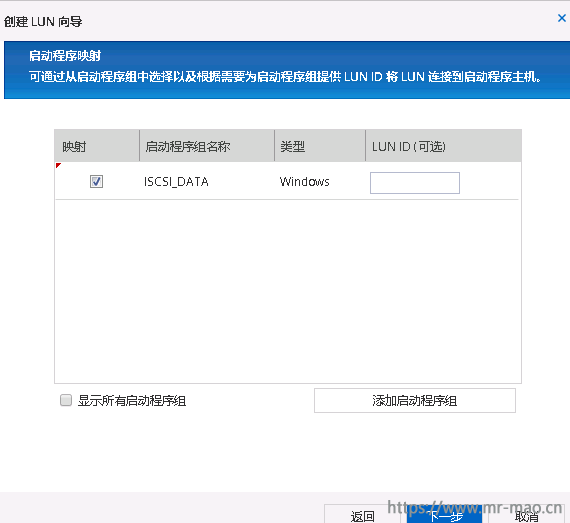

单击下一步,勾选第6步创建好的启动程序组

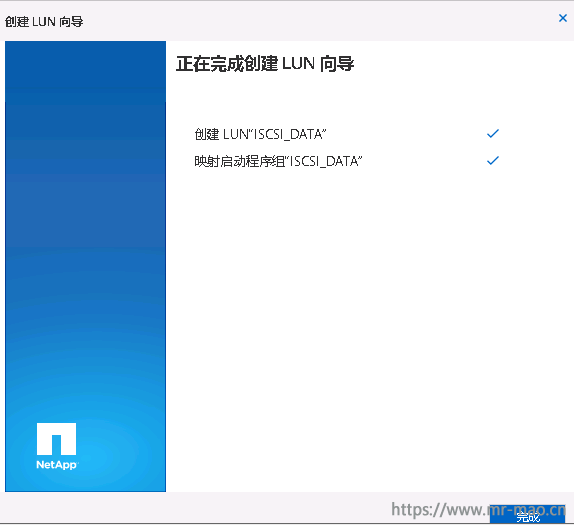

一直下一步,然后点击完成

至此,在存储端的创建、映射工作就完成了

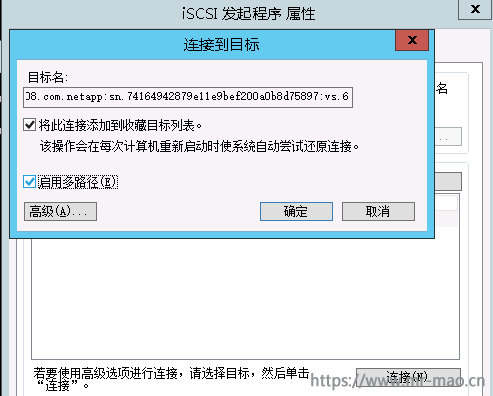

9,在Windows操作系统下,打开ISCSI发起程序,在目标界面,启用多路径

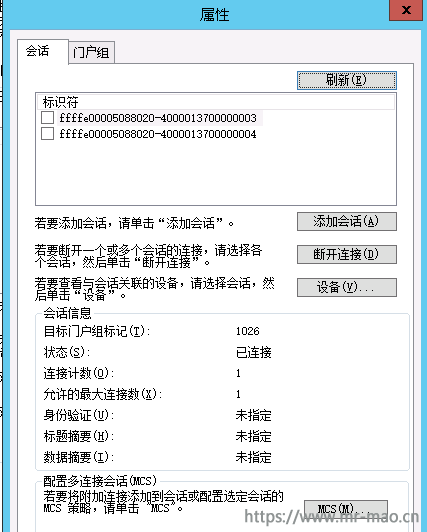

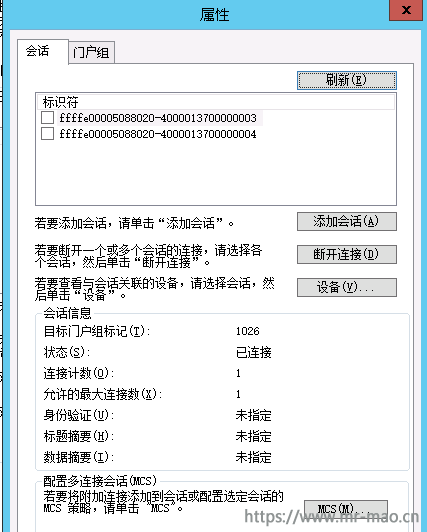

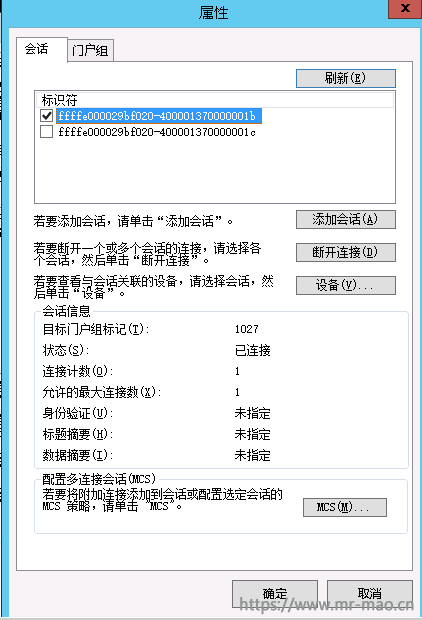

选中netapp的目标设备,单击属性,在会话标签页,显示两组标识符

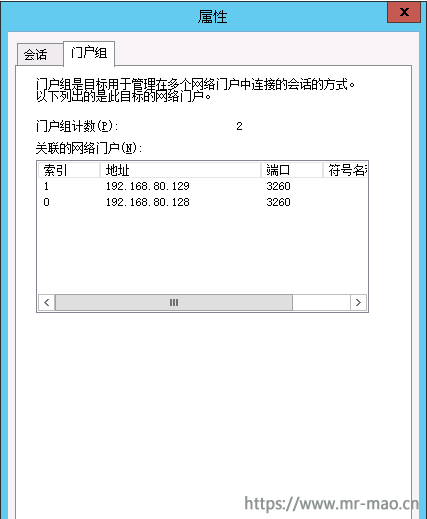

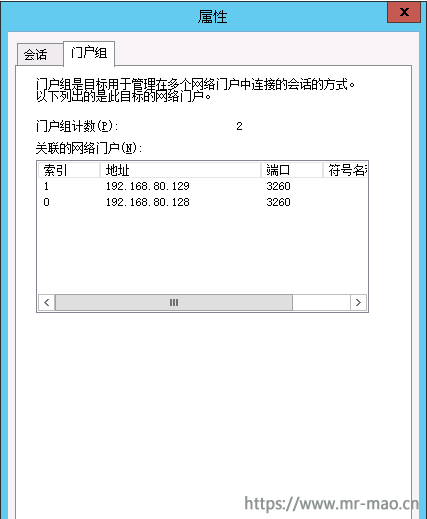

点击门户组,显示了两个ISCSI服务的LIF IP

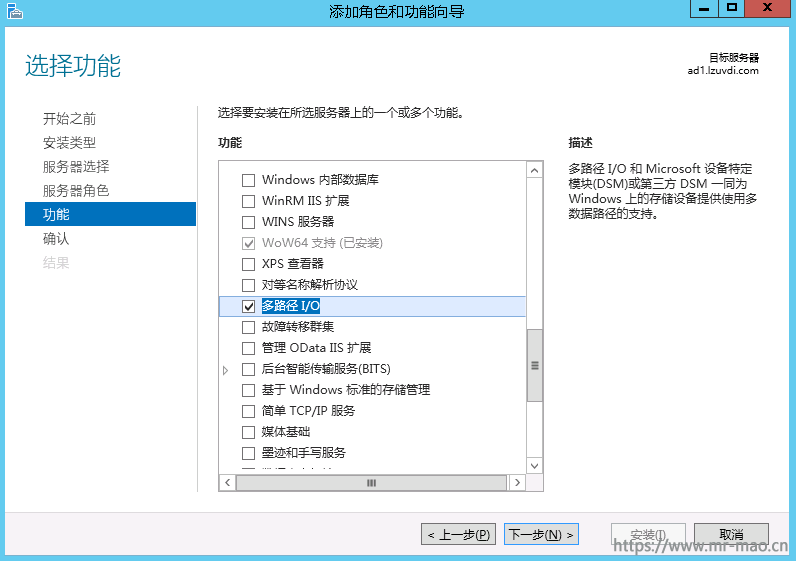

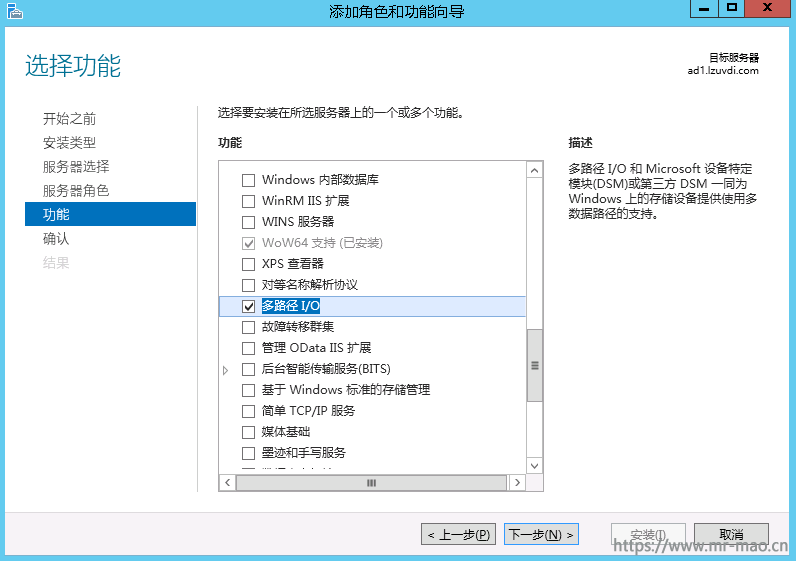

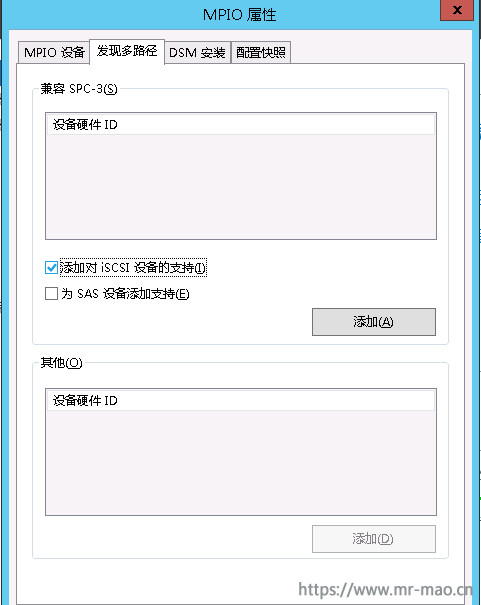

在服务器管理界面添加多路径功能 MPIO

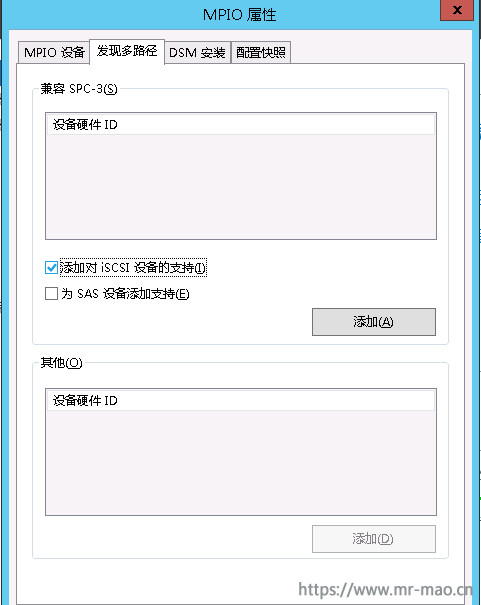

打开管理工具中的MPIO工具,单击发现多路径,选中添加对ISCSI设备的支持,然后点击添加,此时服务器会重启

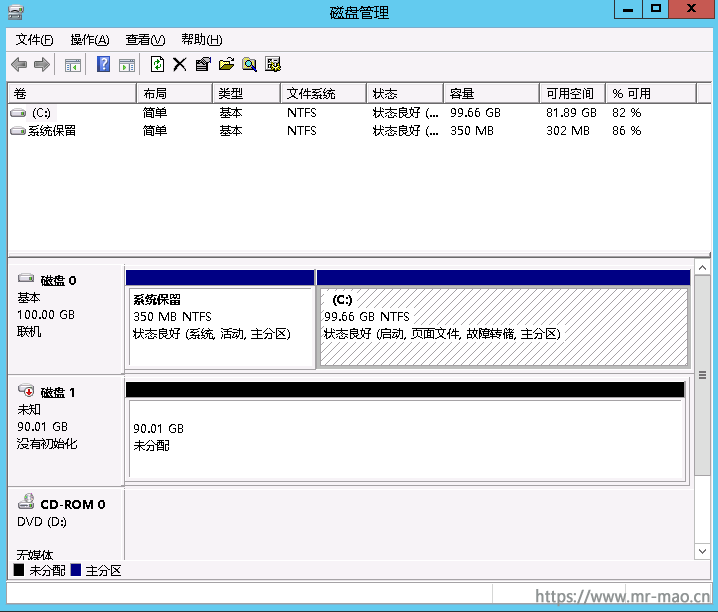

10,初始化磁盘

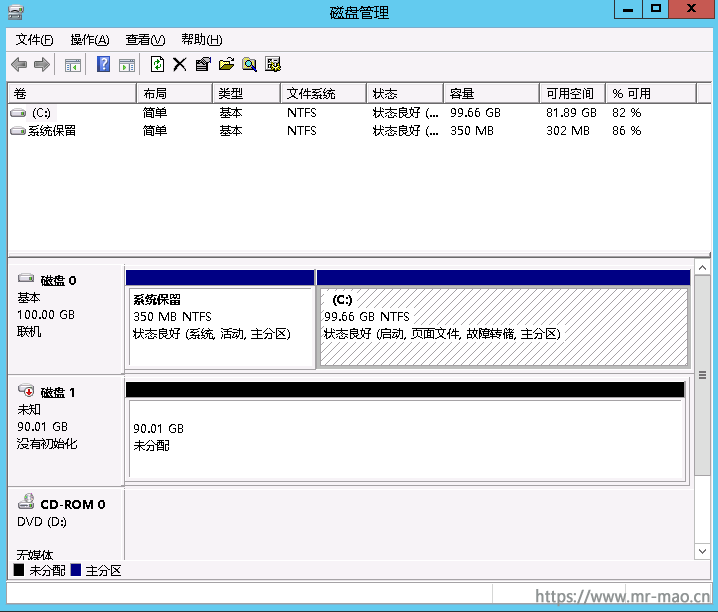

打开磁盘管理,发现一个未初始化的90G的磁盘

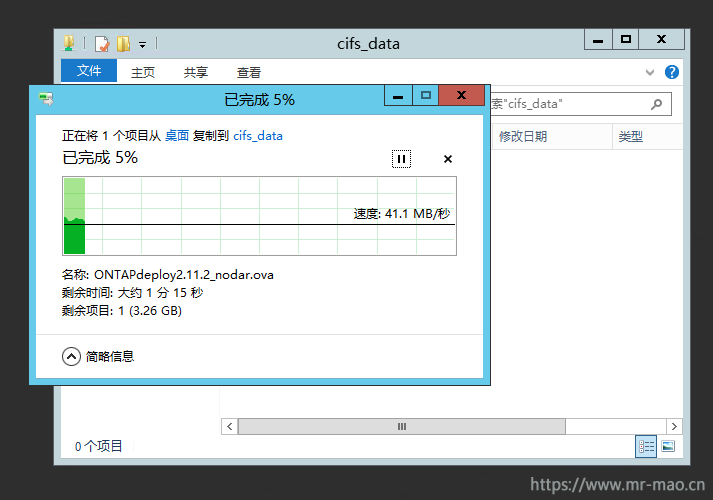

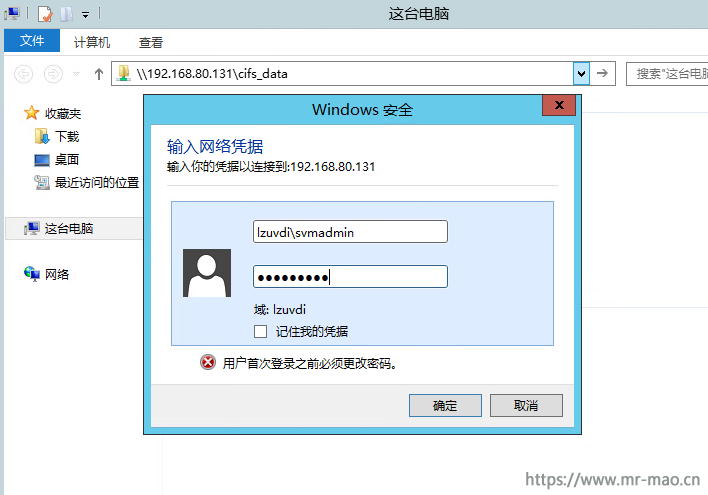

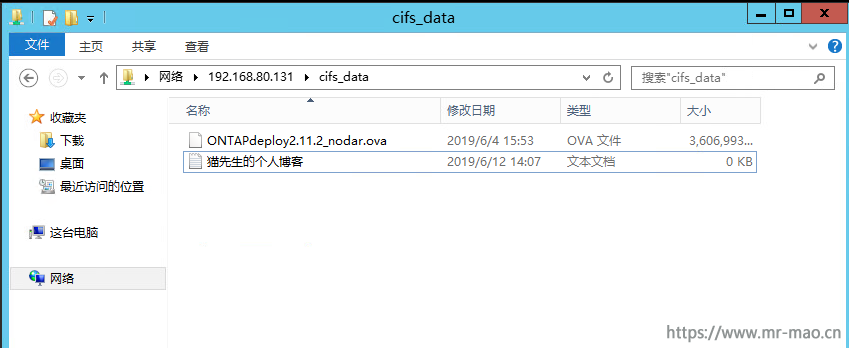

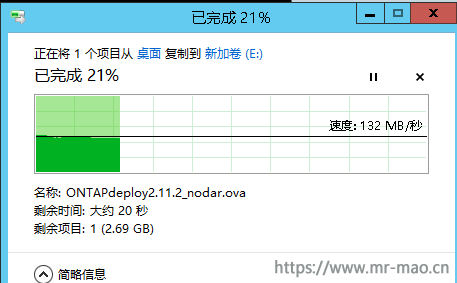

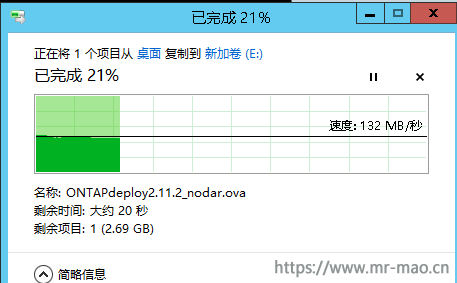

11,测试拷贝

12,测试故障转移

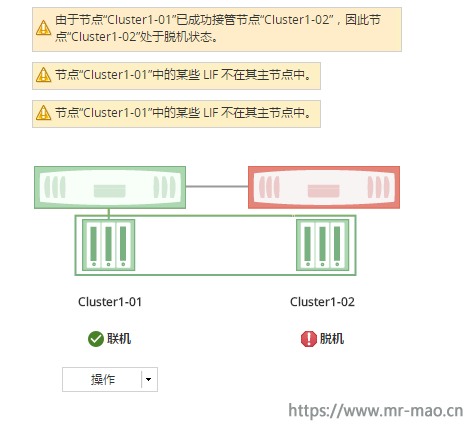

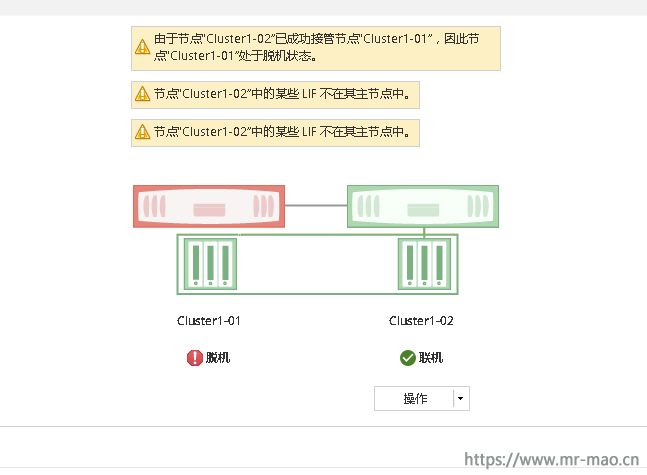

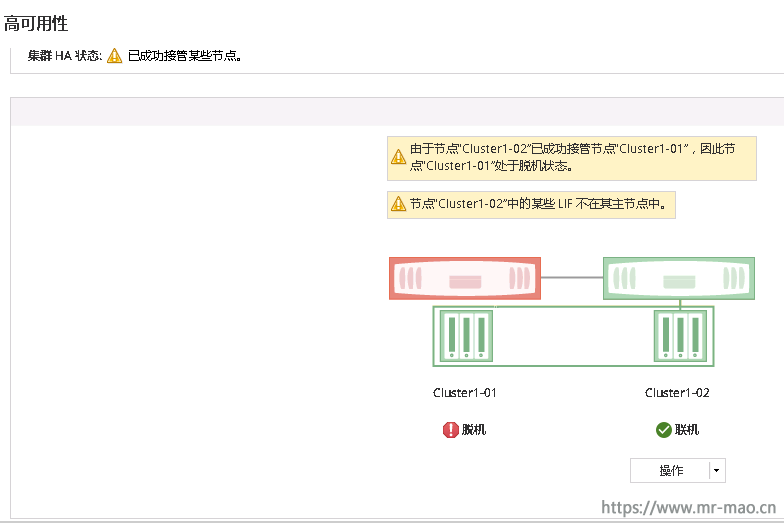

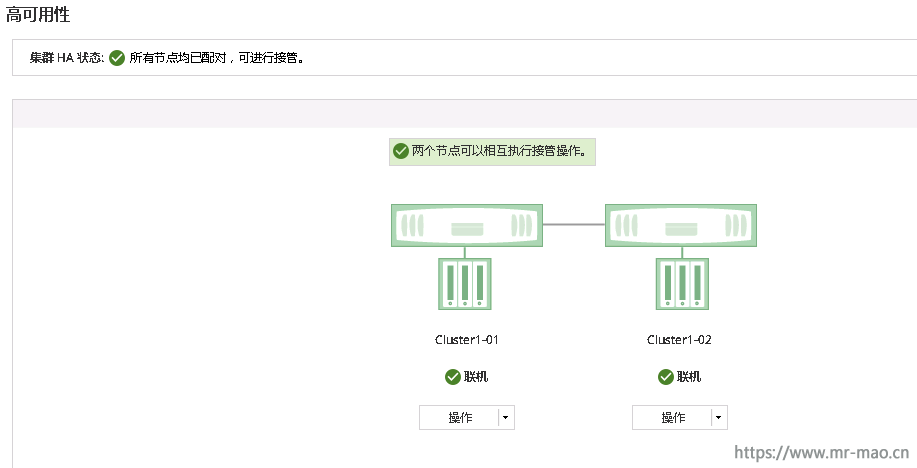

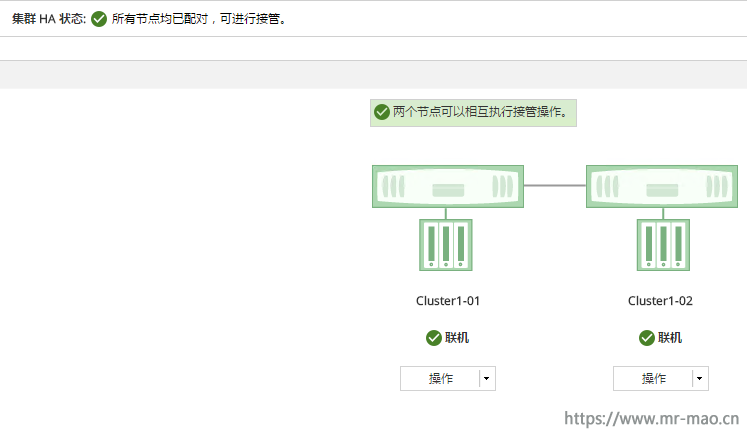

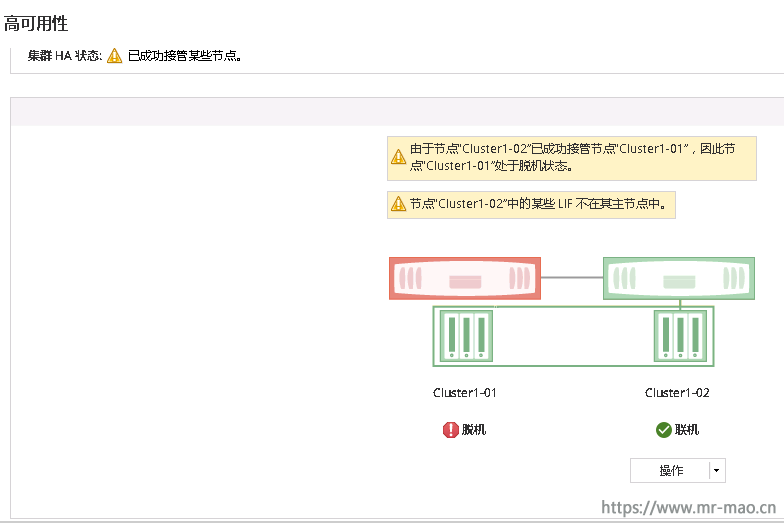

我把A控直接断电,此时,集群管理ip无法连接,等待30秒左右,集群管理系统正常,在集群的高可用状态提示A控已脱机

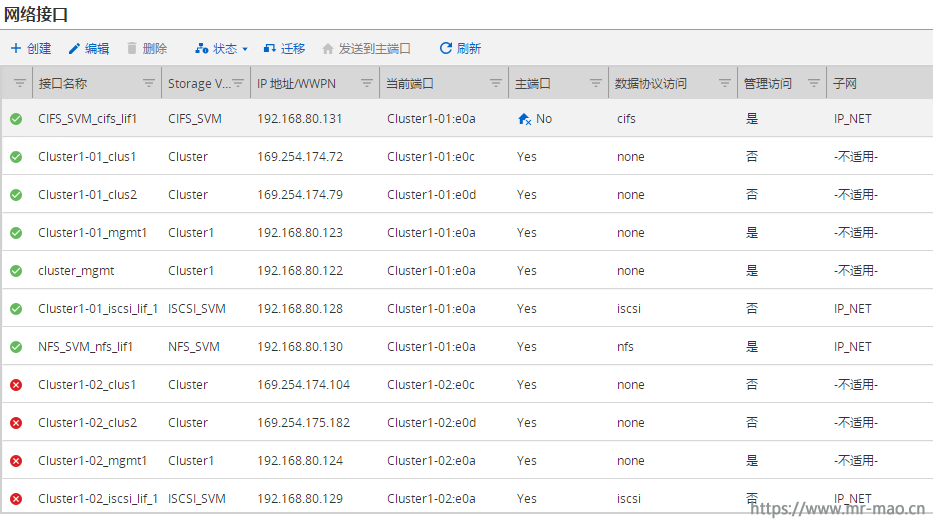

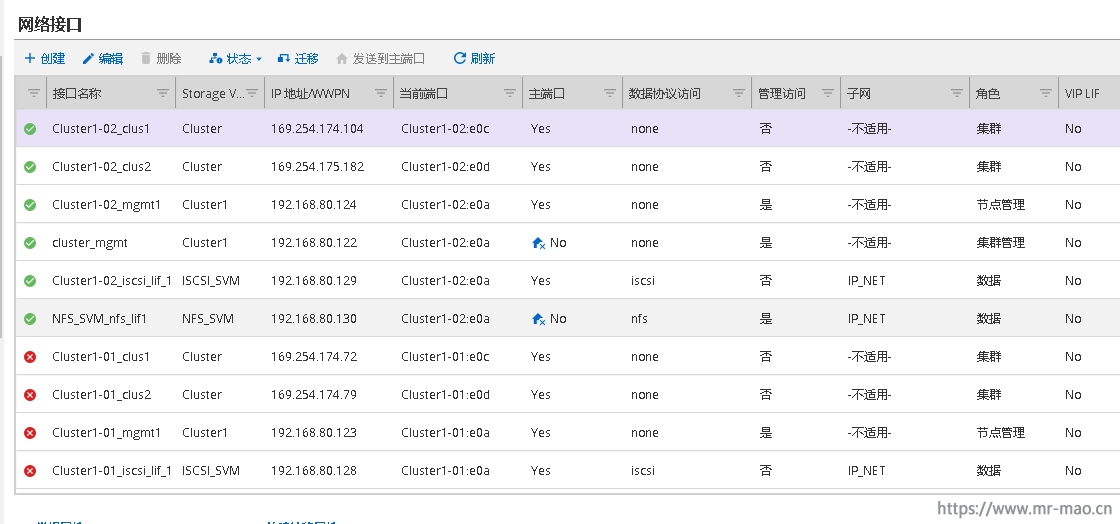

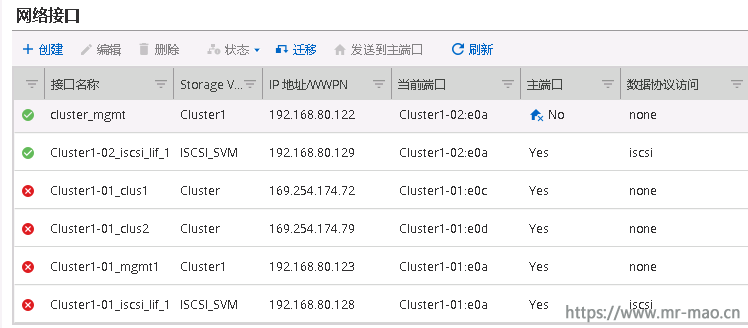

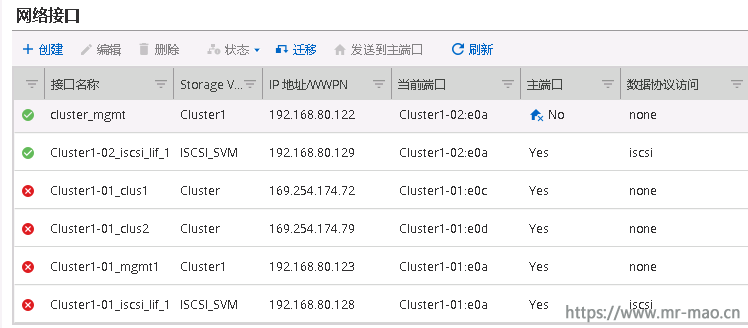

单击网络-网络接口,发现A控的所有接口状态都是未知,在B控的ISCSI LIF IP 192.168.80.129 正常工作

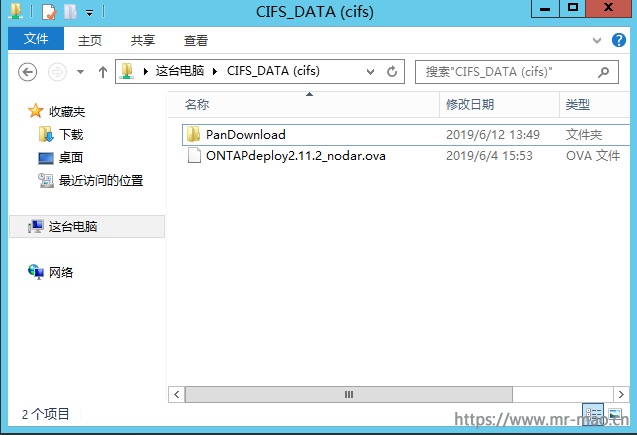

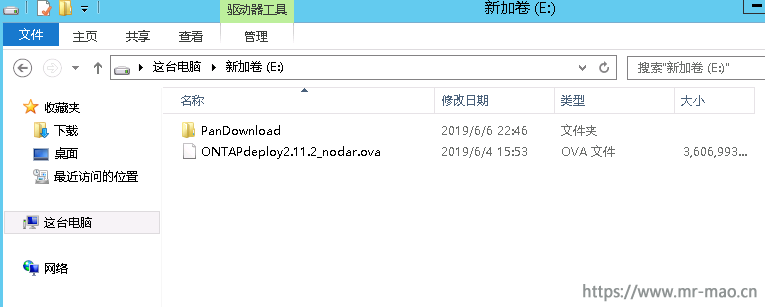

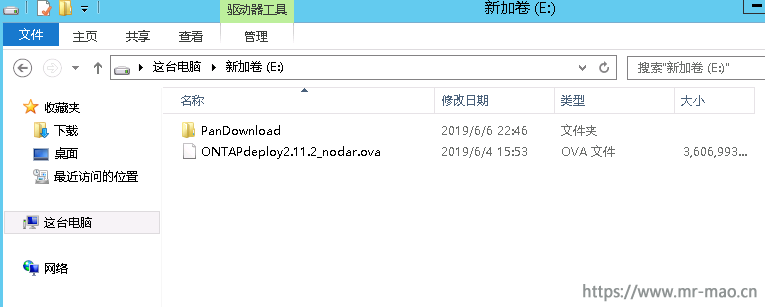

打开计算机,发现之前的ISCSI LUN还在,文件也可以正常写入,说明路径故障已经转移

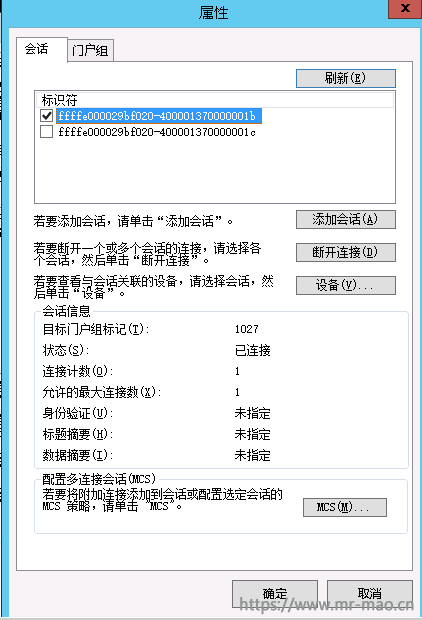

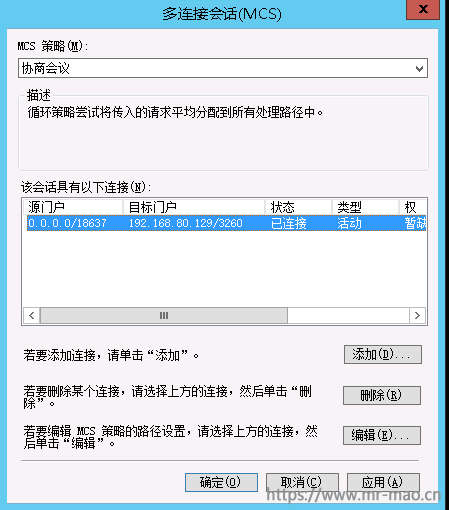

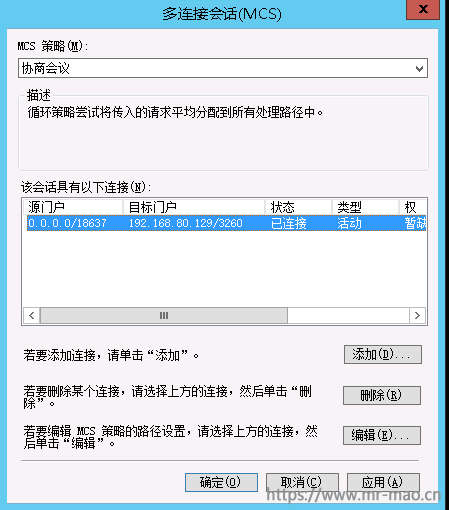

打开ISCSI发起程序,选中netapp 目标,单击属性,在会话标签页,选中一个标识符,单击配置多连接会话 MCS(M)

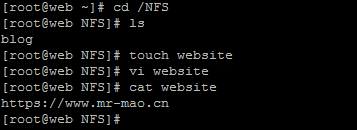

此时,会话的路径已经转移到了192.168.80.129

因篇幅关系,我就不测试B控断电了,大家可自行测试。

12,集群恢复

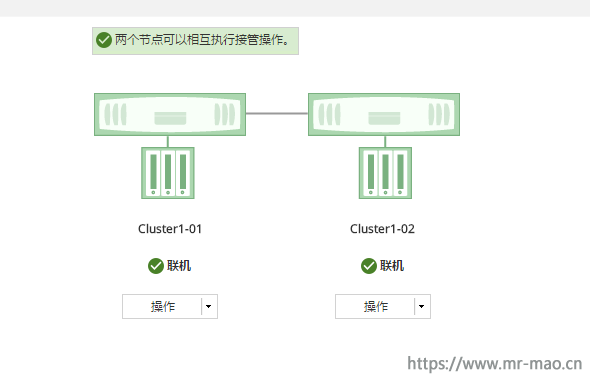

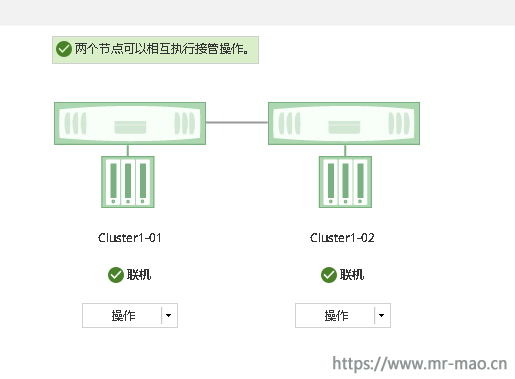

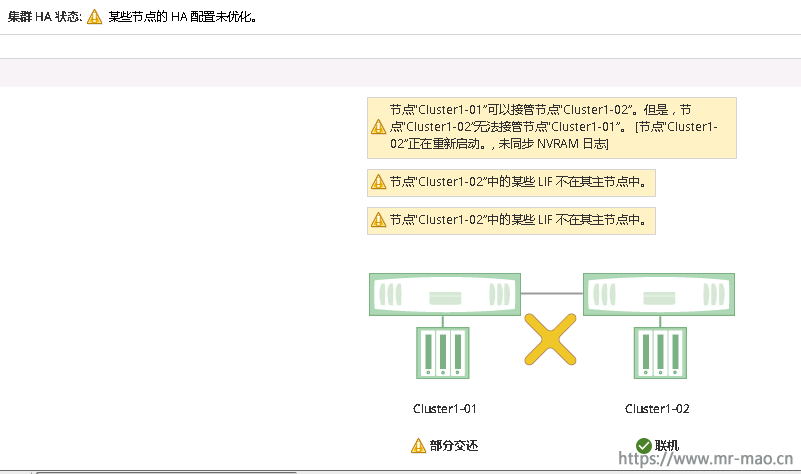

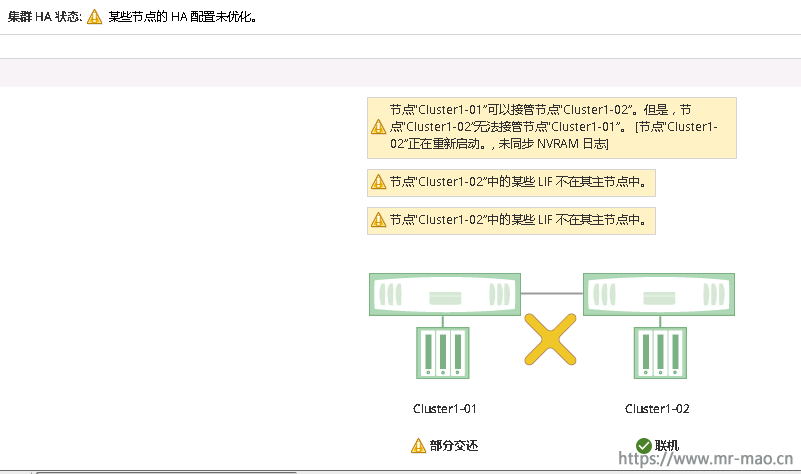

把A控的电源打开,等待大概两分钟左右,集群HA状态如下

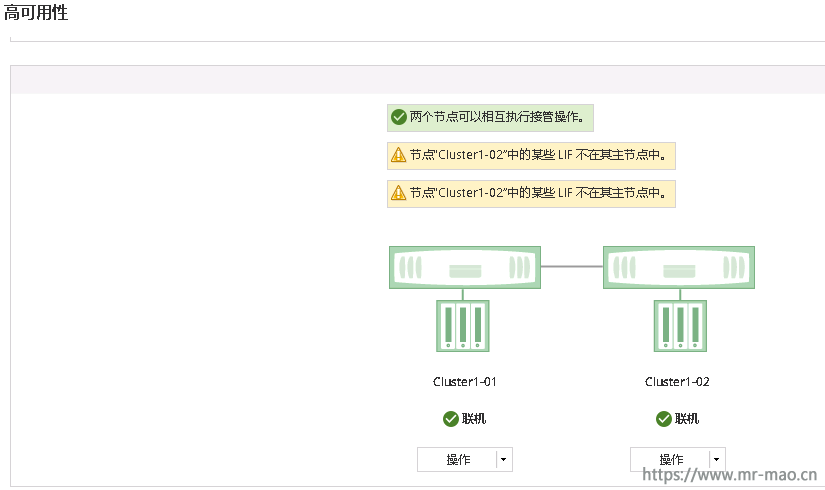

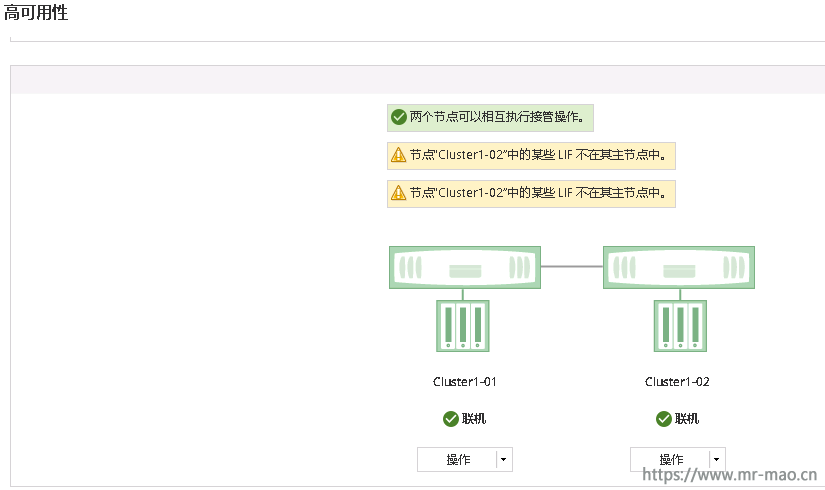

等待大概3分钟左右,集群HA状态如下

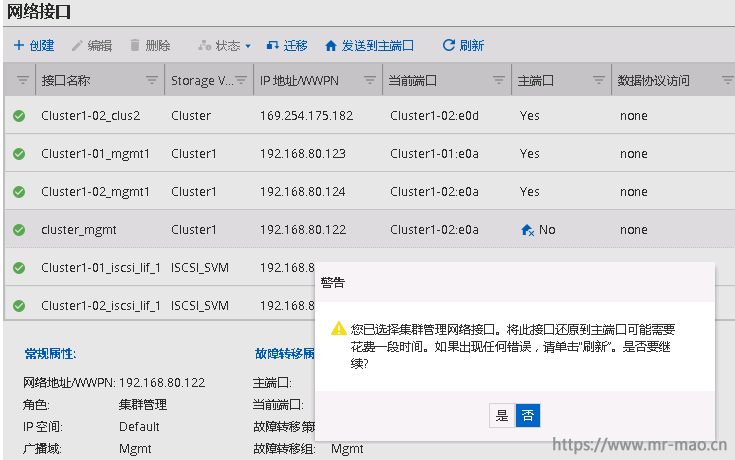

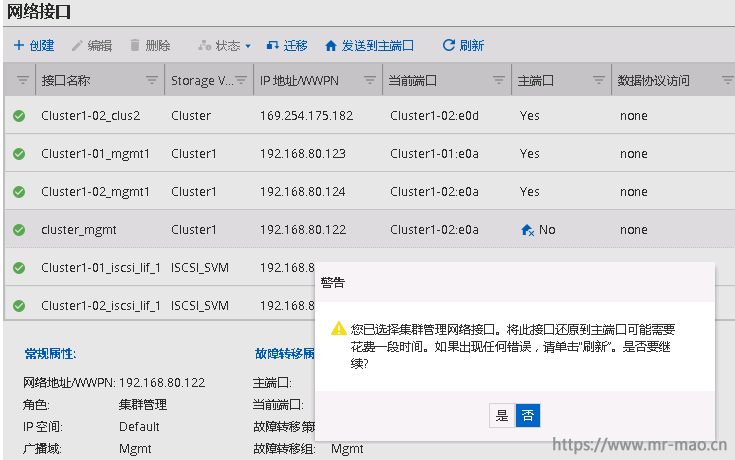

此时,点击网络-网络接口,发现,A控的网络接口状态都已恢复正常,选中cluster_mgmt 端口,单击发送到主端口

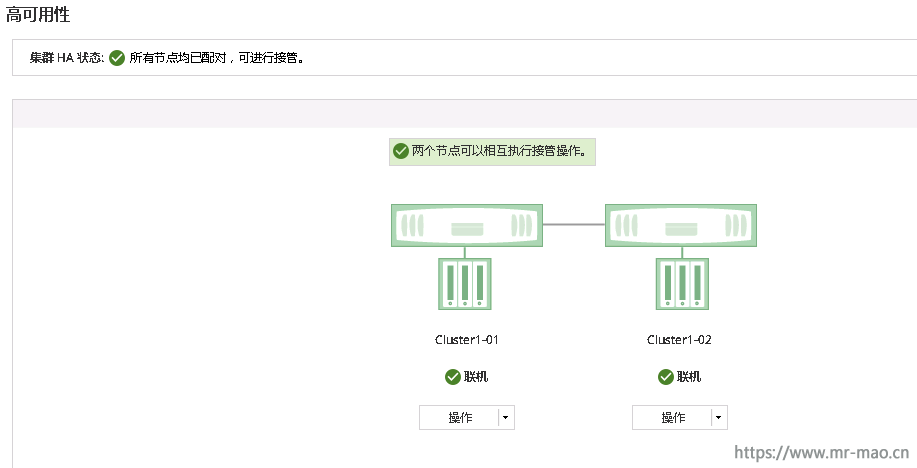

再次查看集群HA状态,已恢复正常

至此,此章节内容完结。

关于netapp 的快照,flexclone ,异步镜像等一些高级功能,等把NFS、CIFS配置完再具体一一测试。