IOPS在线计算器

趴了一套外网的IOPS在线代码,搭建了这个程序,方便各位工程师计算iops。此工具仅供参考!

趴了一套外网的IOPS在线代码,搭建了这个程序,方便各位工程师计算iops。此工具仅供参考!

主流厂商存储竞争分析,包括华为intel、arm产品,戴尔、EMC、联想、H3C、HPE、浪潮、曙光、HDS、红杉、IBM、PURE等厂商的主流产品的参数。

所有的SAN网络都是由小至大,在SAN网络初期,必须对DomainID有一个统一的规划。

如果一台接入交换机设置了Insistent DoaminID 参数同时与现有网络内其他交换机相同的DomainID,当他接入时会发生将另一台未设置IDID参数的交换机的DomainID冲掉的情形,引起不必要的业务中断,因此建议将所有的交换机统一设置Insistent DomainID。

[scode type="share"]全屏查看,浏览效果更佳,回复评论下载附件[/scode]

下面是详细配置文档

最近,发现联想DM存储的ONTAP系统更新到9.7了,就想升级体验下,毕竟实验室的设备还是比较全的。

在support.lenovo.com网站中,通过存储的序列号下载好镜像之后,上传到存储中。

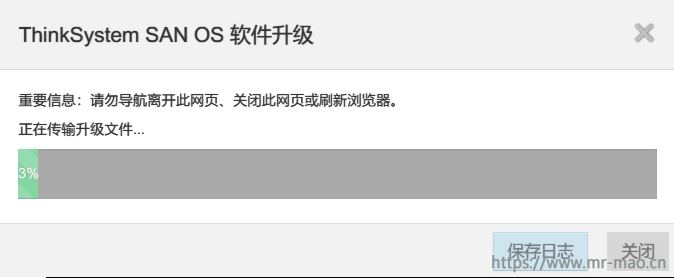

正在上传,一切正常

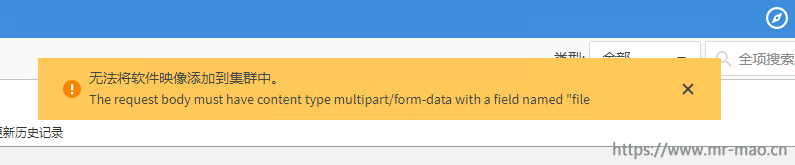

忽然报错

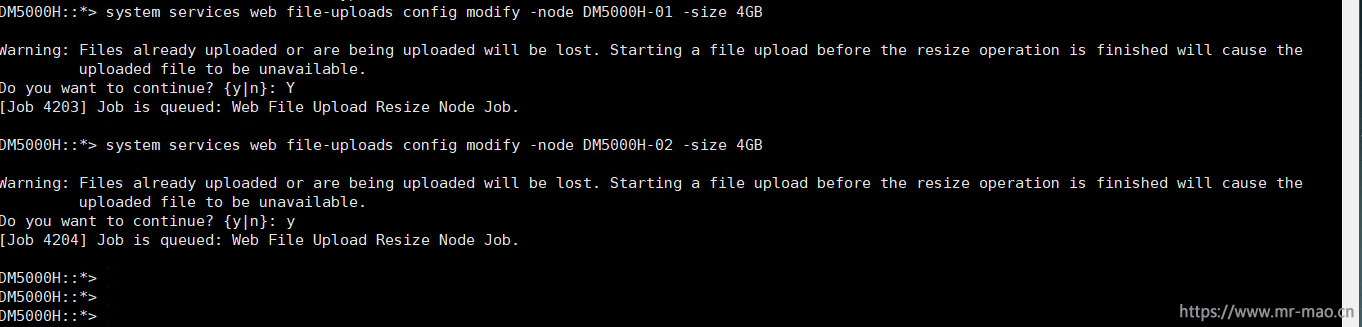

联系netapp原厂工程师,得到如下解决方案

通过ssh登录管理IP,先进入诊断模式

set diag分别对两个节点都执行

system services web file-uploads config modify -node node名称 -size 4GB比如我的

然后再退出诊断模式

set admin重新登录管理界面,继续上传,上传成功!

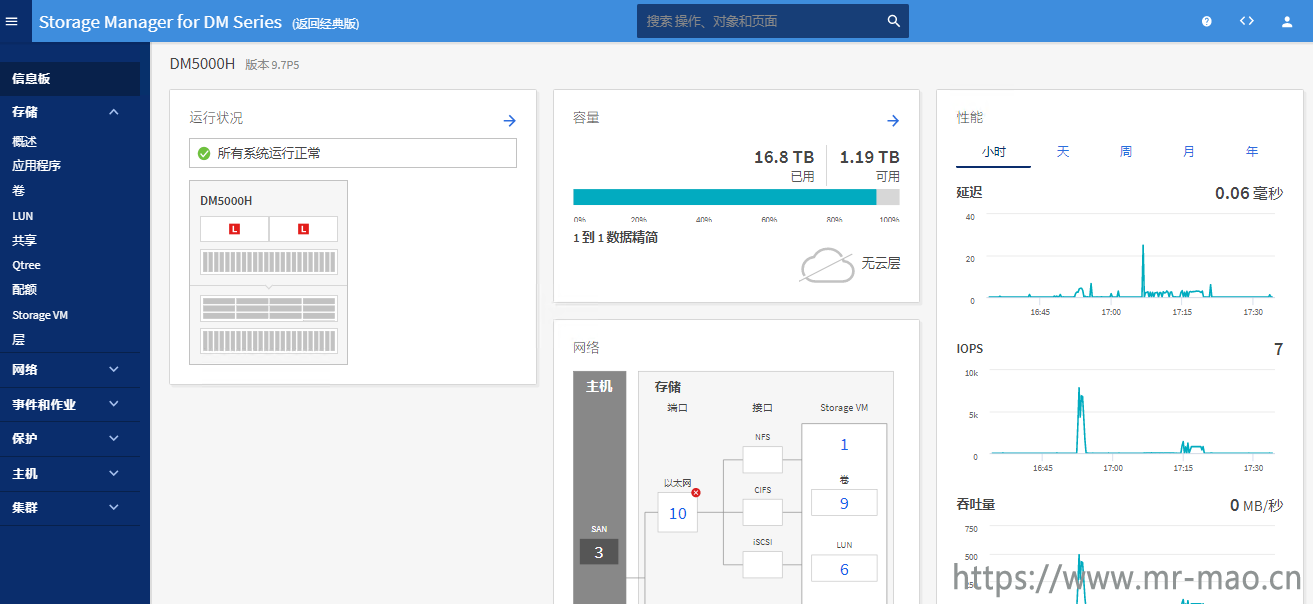

升级成功

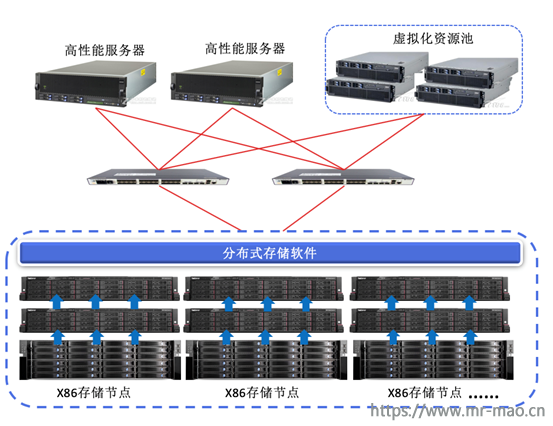

分布式存储系统,是将数据分散存储在多台独立的X86服务器上,通过通用的存储协议对外提供FC、ISCSI、RBD、NAS、S3等存储接口,每个存储服务器节点既能够进行数据存放和性能加速,也同时提供数据控制和存储接口对接,没有单点故障,每个节点都可以对外提供数据吞吐,性能随着存储节点的增多会线性上升,分布式存储系统采用可扩展的系统结构,利用多台存储服务器分担存储负荷,它不但提高了系统的可靠性、可用性和存取效率,并且易于扩展。

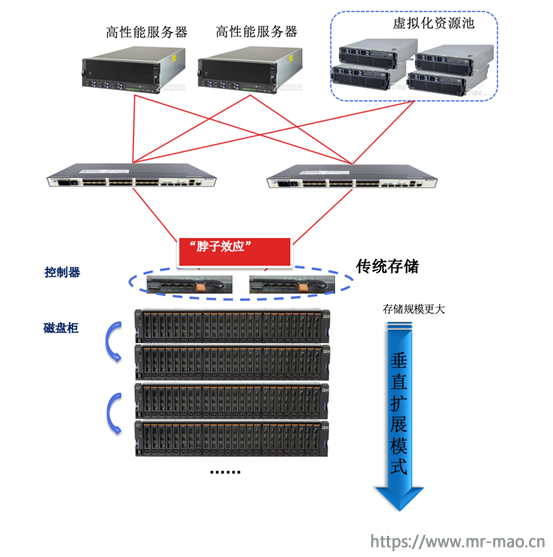

拓扑架构:

集中式存储系统指由一台或多台主控制器组成中心节点,各数据设备级联部署,数据集中存储于这个中心节点中,并且整个系统的所有业务单元都集中部署在这个中心节点上,系统所有的功能均由其集中处理,中心节点统一对外提供FC、ISCSI、NAS存储接口。也就是说,集中式系统中,每个终端或客户端及其仅仅负责数据的录入和输出,而数据的存储与控制处理完全交由主机来完成。集中式系统最大的特点就是部署结构简单。

拓扑架构:

传统集中式存储架构的局限性主要体现在以下几个方面:

分布式存储往往采用分布式的系统结构,利用多台存储服务器分担存储负荷,利用元数据定位存储信息。它不但提高了系统的可靠性、可用性和存取效率,还易于扩展,将通用硬件引入的不稳定因素降到最低。优点如下:

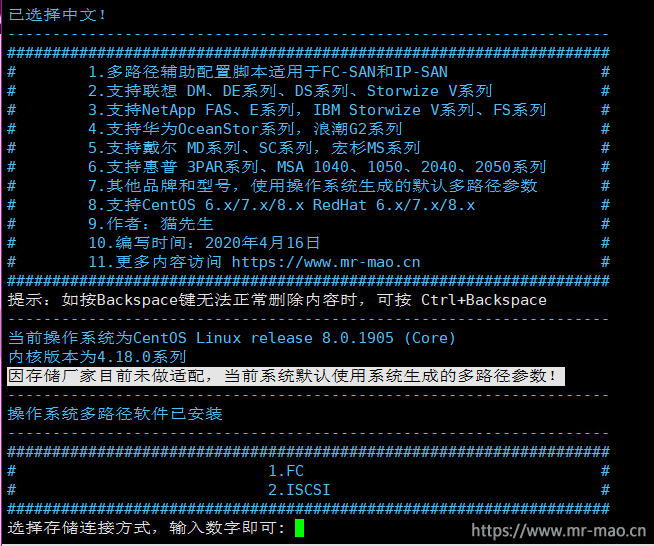

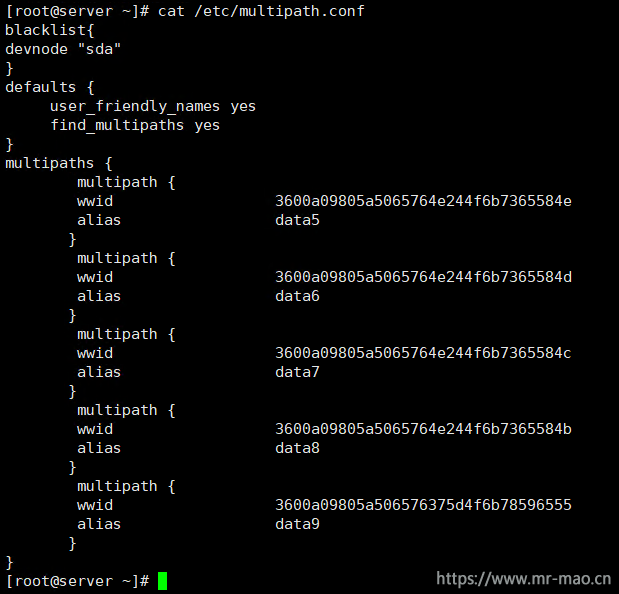

为存储配置多路径,各位工程师都不陌生。在Linux下配置multipath,更不在话下,mpathconf --enable 一条命令走天下,更是老手的惯例,因为mpatha、mpathb、mpathc、这种名称也不会影响使用。但是,给存储卷定义别名就显得不那么粗狂,使用厂商推荐的多路径参数,更显得专业,现在配置多路径的自动化交互式脚本横空出世,极大的方便了各位工程师。

之前写了手动配置多路径的文档Linux操作系统配置多路径通用教程

[scode type="red"]仅适用于初次配置![/scode]

脚本功能:

1.多路径辅助配置脚本适用于FC-SAN和IP-SAN

2.支持联想 DM、DE系列、DS系列、Storwize V系列

3.支持NetApp FAS、E系列,IBM Storwize V系列、FS系列

4.支持华为OceanStor系列,浪潮G2系列

5.支持戴尔 MD系列、SC系列,宏杉MS系列

6.支持惠普 3PAR系列、MSA 1040、1050、2040、2050系列

7.其他品牌和型号,使用操作系统生成的默认多路径参数

8.支持CentOS 6.x/7.x/8.x RedHat 6.x/7.x

9.支持中英选择5月14日更新:

修复Lenovo DE系列存储新版本微码下20m管理分区的识别

优化判断逻辑4月16日更新:

1,新增支持CentOS 8.x/RedHat 8.x

2,优化多个判断逻辑

备注:因为存储厂商目前并未适配8系列系统,我多次测试使用7系列的官方参数,会有问题。

所以会默认使用8系列系统生成的多路径参数,不加入任何官方参数。[scode type="blue"]已付费用户,联系我获取最新版本,或者有其他需求,如增加功能,或者修改直接联系我即可[/scode]

linux 8系列下部分截图

[scode type="blue"]上述列出的品牌及型号,会使用厂商推荐的最佳多路径参数,没有列出的品牌和型号,则使用操作系统生成的默认多路径参数,如你使用的存储不被支持,则会有相应的提示![/scode]

在使用的过程中如果遇到什么问题,或有什么建议或者需要增加品牌或者型号的参数,加我微信交流,微信二维码在文章底部。

部分截图:

屏蔽20M管理分区截图:

惠普3PAR存储 选择主机定义截图:

[scode type="blue"]创作脚本不易,打赏后获取脚本下载链接!获取后加我微信,后续更新版本,会通过微信传递[/scode]

设置服务IP:

satask chserviceip -serviceip 192.168.70.121 -gw 192.168.70.1 -mask 255.255.255.0重置密码:

satask resetpassword配置集群:

satask mkcluster -clusterip 192.168.70.125 -gw 192.168.70.1 -mask 255.255.255.0satask restartservice -service tomcatcleardumps -prefix /home/admin/upgradecleardumps -prefix /dumps/1,新建池

mkmdiskgrp -ext 1024 -guiid 0 -name pool -warning 80%2,新建阵列

mkarray -level raid5 -drive 0:1:2:3:4:5:6:7:8:9 pool3,新建分布式阵列

mkdistributedarray -level raid6 -driveclass 3 -drivecount 40 poolapplysoftware -abortchiogrp -feature flash -size 256 io_grp0

chiogrp -feature flash -size 256 io_grp1

chiogrp -feature remote -size 256 io_grp0

chiogrp -feature remote -size 256 io_grp1将 I/O 组 0 中的 RAID 内存量更改为 512 MB 的调用示例

chiogrp -feature raid -size 512 0(任意一个即可)

satask chenclosurevpd -resetclusterid

satask chvpd -resetclusterid命令1

svctask chenclosurecanister -reset -canister 1 1命令2

svctask chenclosurecanister -reset -canister 2 1备注:升级微码,一劳永逸。

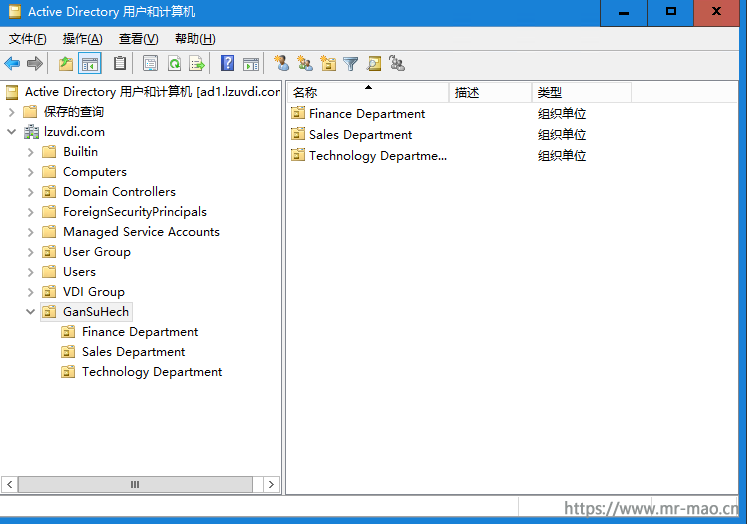

环境:ONTAP 9.6 AD:Windows 2016

要求:公司购买一台dm3000h,跑nas存放资料,三个部门,每个部门都需要单独的文件夹,部门之间无法互相访问,并且部门成员只有使用共享文件夹的权限,无共享配置权限。部门内部,不同的成员权限不同。

存储初始化以及创建SVM参考博客内的文章,此次主要以权限配置为主。

CIFS如何加域,参考这里LenovoNetapp ONTAP Select系列教程(四)之配置SMB/CIFS

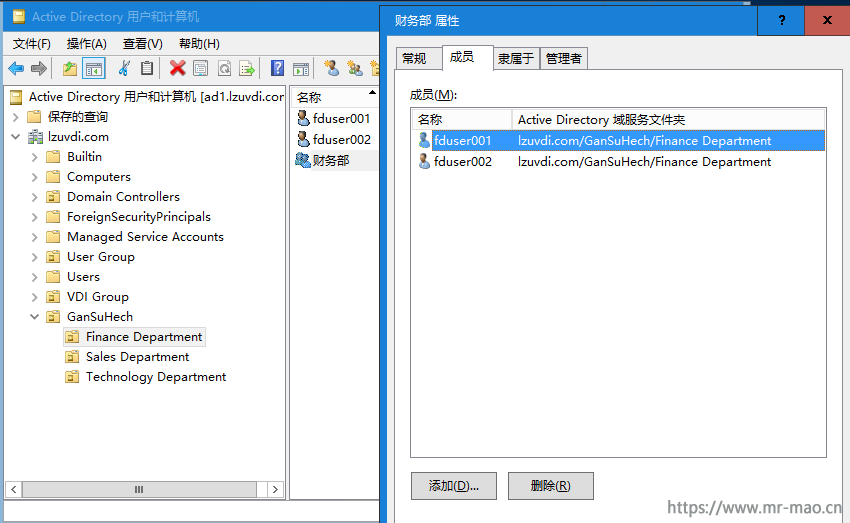

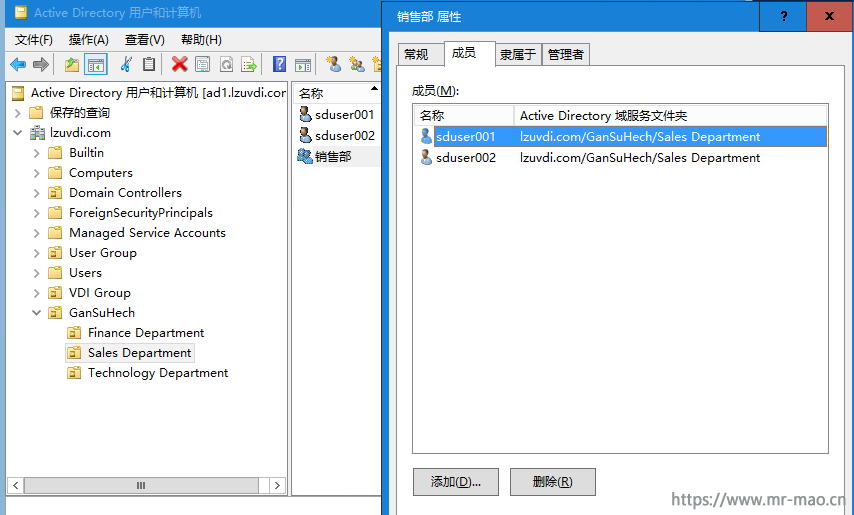

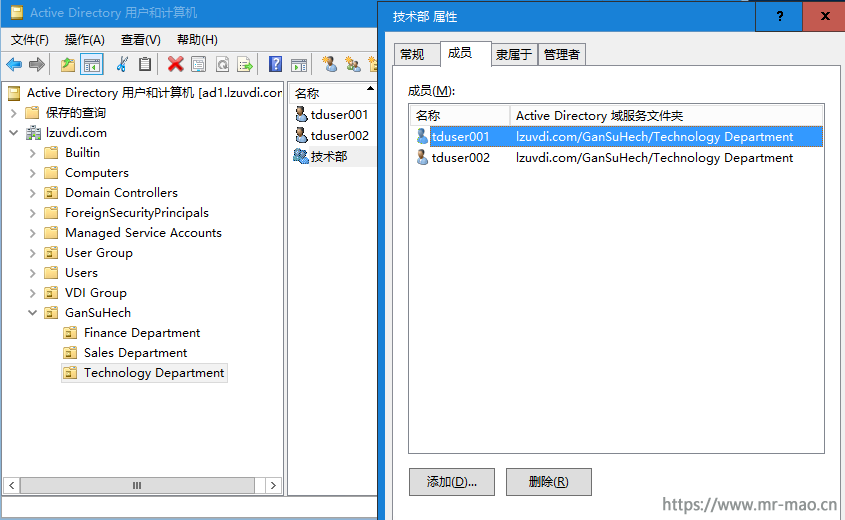

1,创建部门组织单位,分别是:Finance Department、Sales Department、Technology Department,每个组织单位包含一个组,每个组下有不同人数的成员。各部门的成员加入各自组织单位下的组。

财务部成员

销售部成员

技术部成员

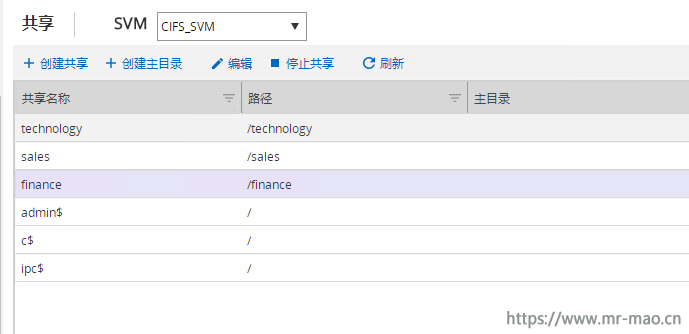

2,创建各部门的共享文件夹,分别是finance、sales、technology

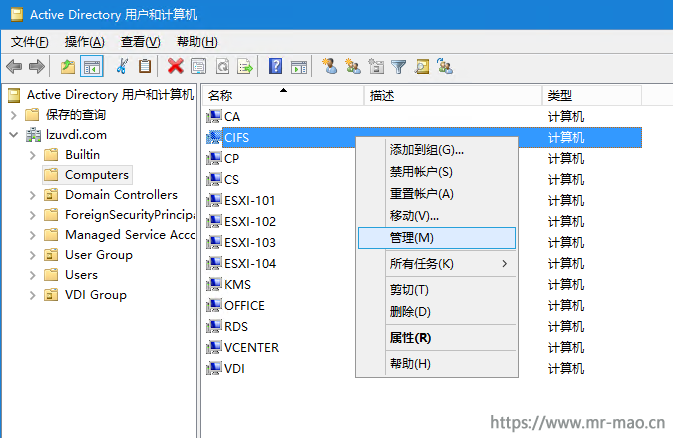

3,打开域控用户管理器,点击Computers,选中CIFS服务器,右键,点击管理。

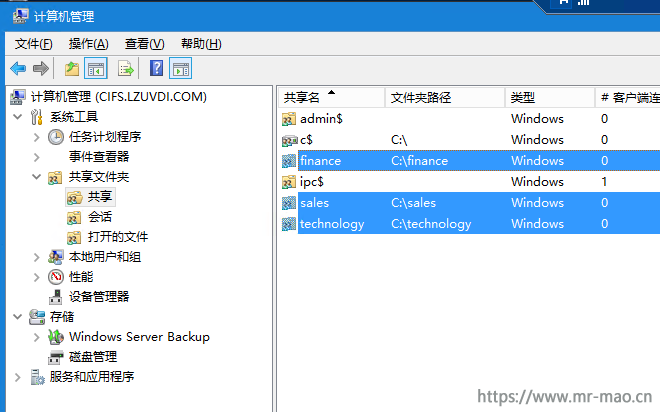

出现cifs服务器上配置的3个共享文件夹

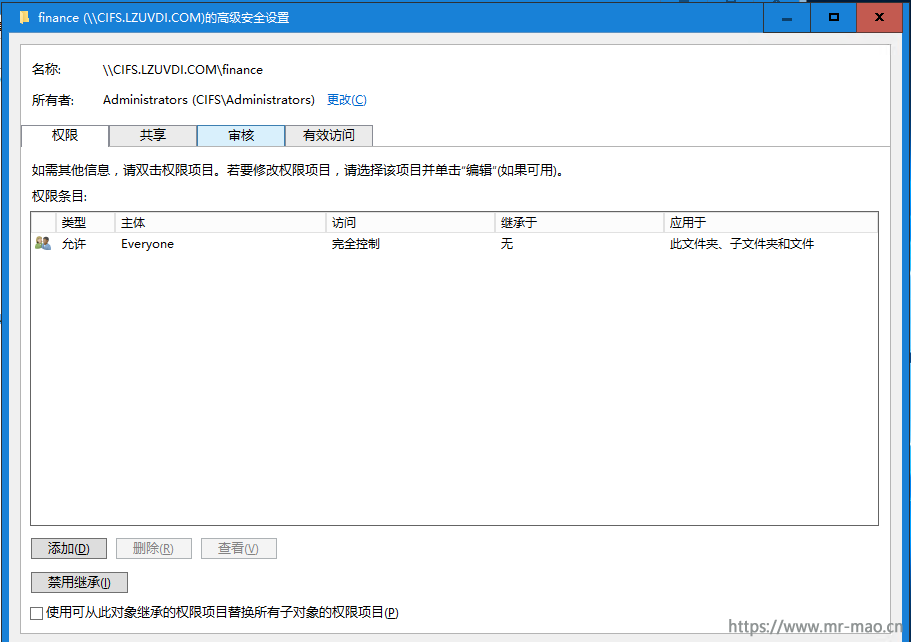

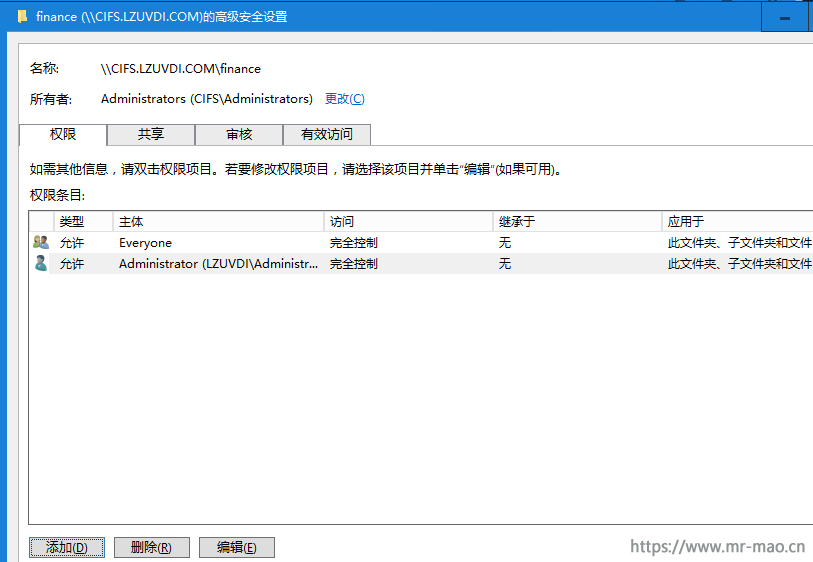

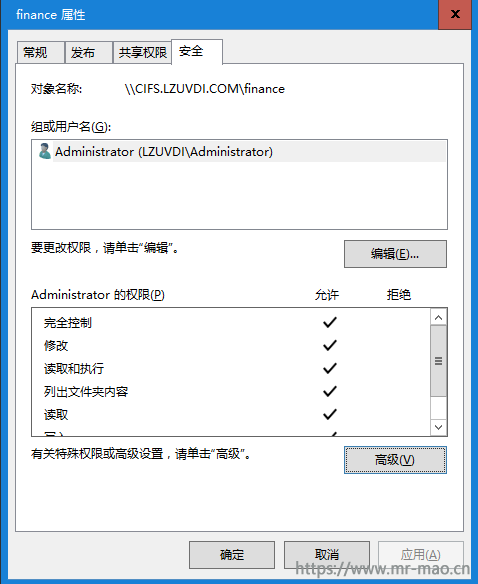

4,右键单击finance文件夹,点击属性,点击安全标签,单击右下角高级,弹出高级安全设置窗口,

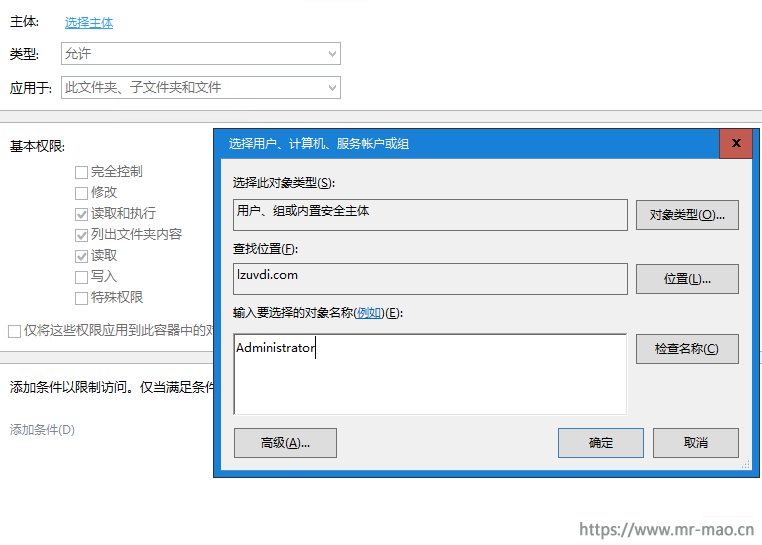

点击左下角添加,单击选择主体,输入组名称:Administrator,单击确定,

在基本权限中,单击完全控制,点击确定。

删除Everyone的权限,点击确定。这样域控的管理员有了对共享文件夹的完全控制权限

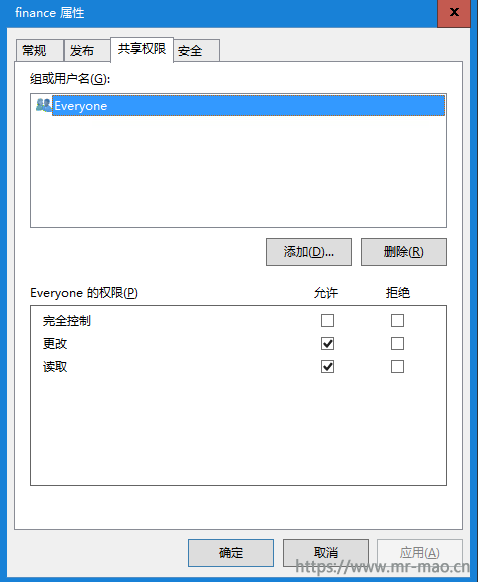

5,单击共享权限标签,取消Everyone的完全控制权限

重复上述4-5步,配置其他共享文件夹权限。

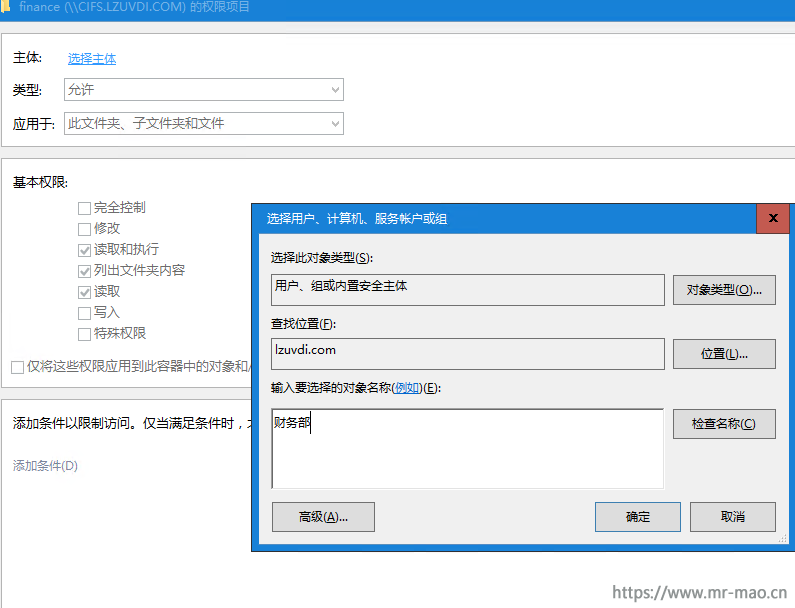

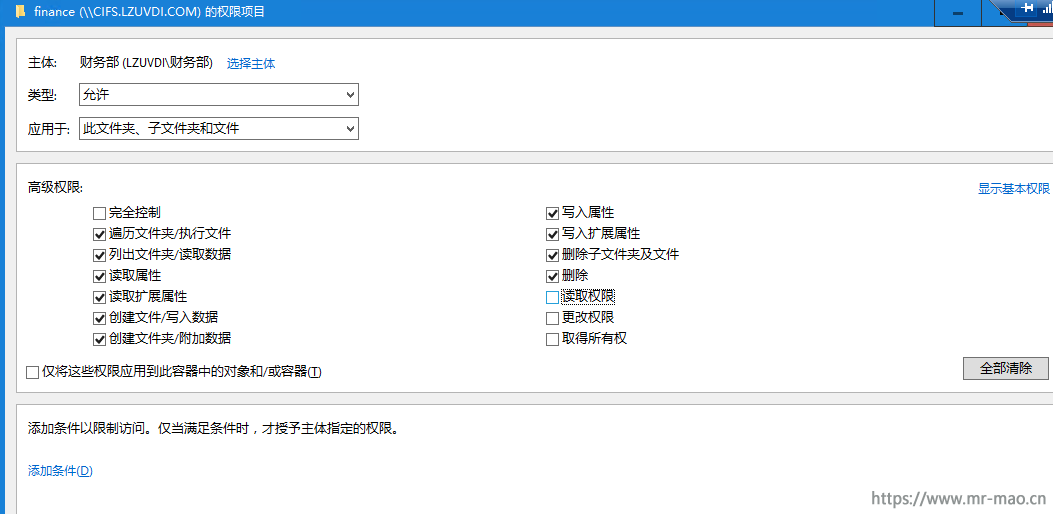

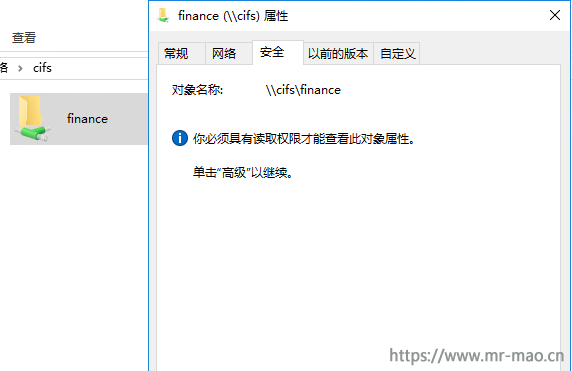

1,在CIFS服务器管理界面中,打开finance文件夹属性,点击安全标签,单击高级,点击左下角添加,点击选择主体,输入:财务部,单击确定

2,在权限配置栏中,选择相应的权限,此处,我给了除读取权限、更改权限、取得所有权之外的其他权限,正式环境中,根据需求选择即可,如需细分用户权限,看第三部分。

重复上述步骤设置sales、technology的权限

3,测试文件夹权限,由于篇幅关系,我只测试一个组。

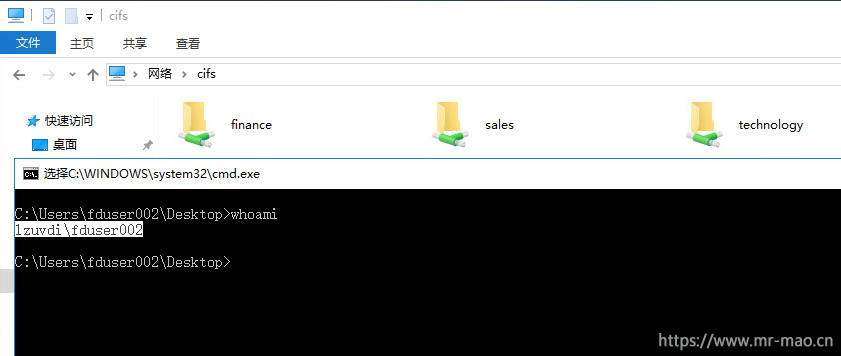

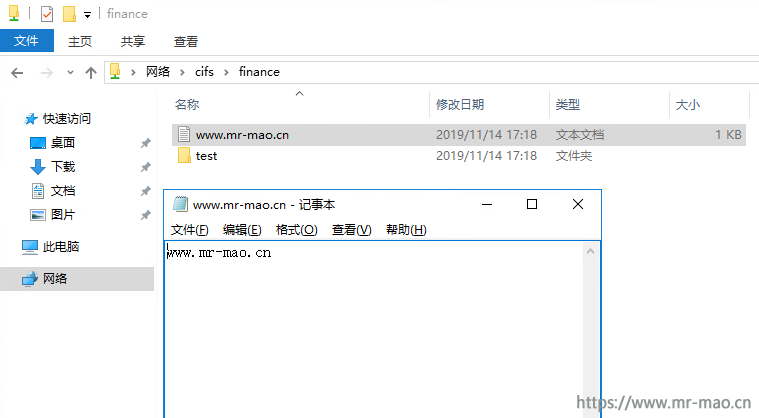

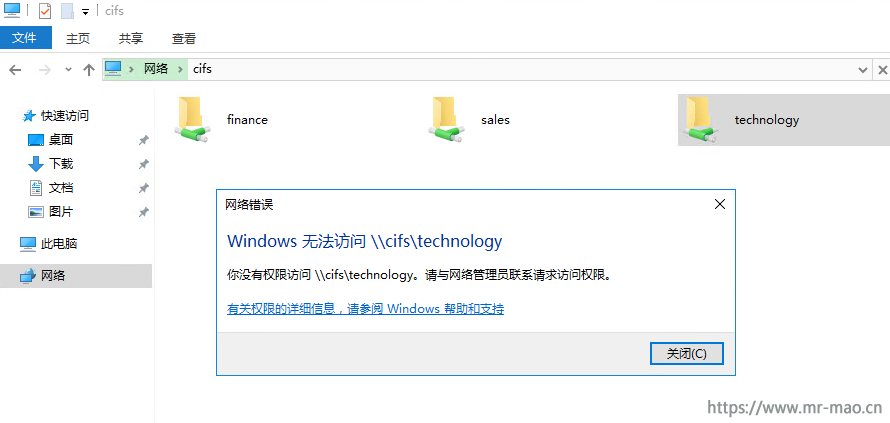

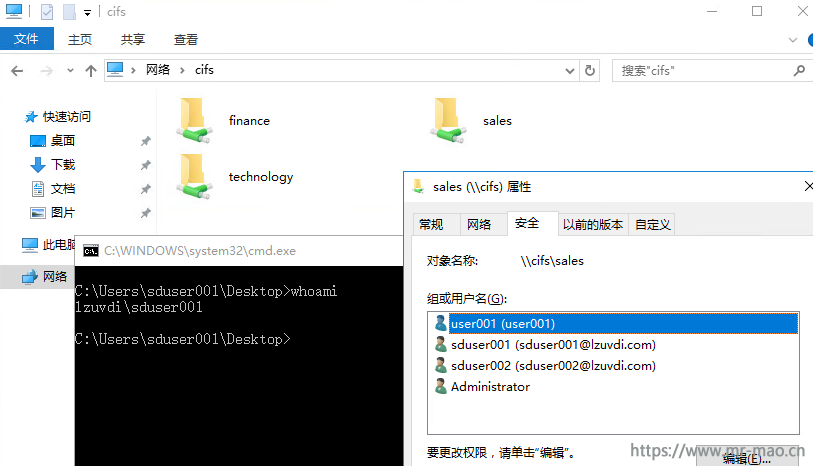

登录财务部门的fduser002用户,在浏览器中打开\\cifs,出现三个部门的共享文件夹。

可以正常打开财务部所属的共享文件夹,正常新建,编辑,删除文件,正常新建,删除文件夹。

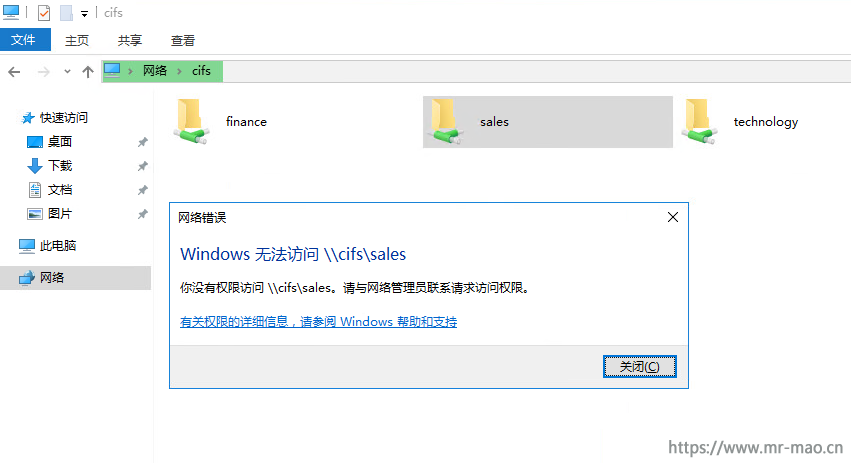

测试打开销售部门文件夹,提示无权限

测试打开技术部门文件夹,提示无权限

测试用fduser002用户编辑文件夹权限,提示无权限

根据上述配置只能统一配置各部门权限,现在要求部门领导可以更改权限,某些用户无法删除文件等等要求。

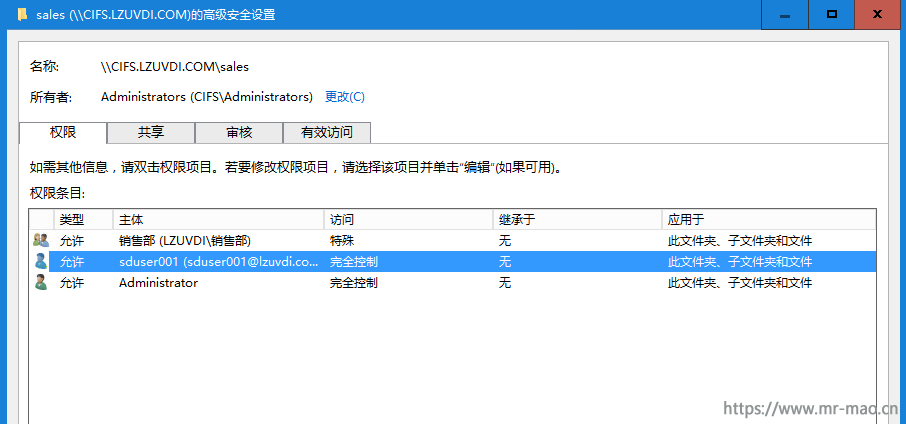

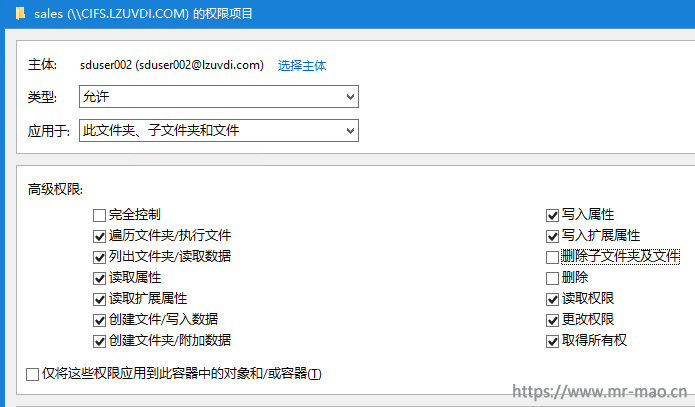

要求:sduser001是部门领导,需要能更改权限,sduser002是实习生,不能随意删除文件。

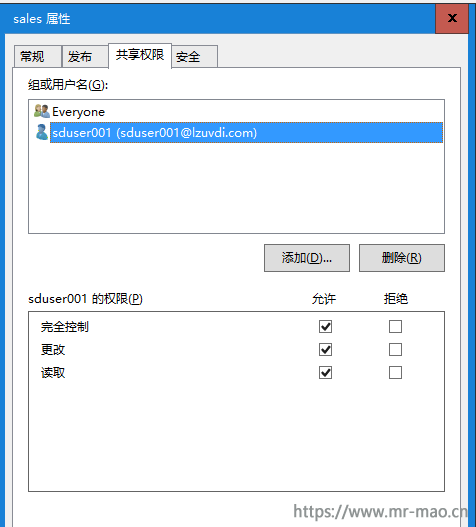

1,在sales文件夹的权限中添加sduser001的权限为完全控制

2,在sales文件夹的权限中删除销售组,添加sduser002用户,取消删除权限,因为组的权限级别优先于用户,不删除组,用户权限继承于组,我这里用户就两个,如果用户较多,那么相同的权限放到同一组,不同的权限建立不同的组,这样只加入组即可,不用一个一个的添加用户设置权限

3,在共享权限标签中,添加sduser001,权限为完全控制

4,测试权限

sduser001可以正常编辑权限,赋予user001账号所有权限。

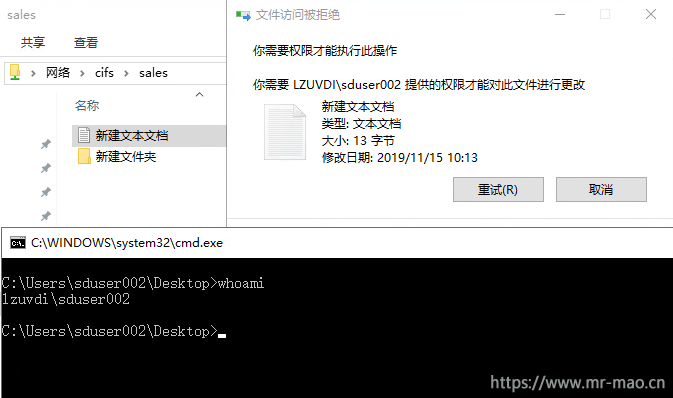

sduser002 无法删除文件和文件夹

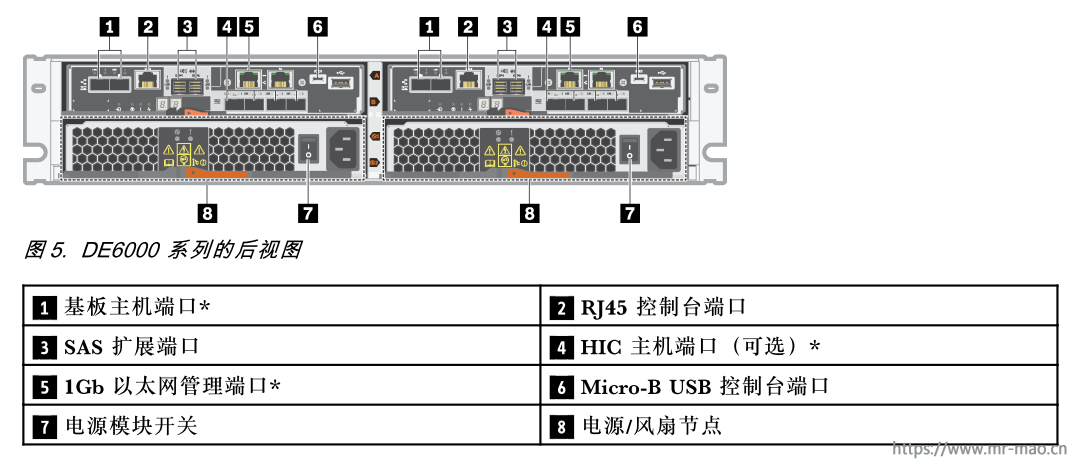

联想的DE系列存储配置非常简单,和以前的ibm ds系列配置方式一样,并且现在加入了web界面,还是中文,简直就是即点击用的设备。可见联想为了方便用户做了多少优化工作。即便是这样简单,但是还是有人一直在找教程,这里写一下,方便大家。

1,连接存储

使用网线将控制器 A 端口( P1 )连接到笔记本电脑的以太网端口,笔记本配置以下地址

IP 地址: 192.168.128.100

子网掩码: 255.255.255.0

[scode type="yellow"]备注:根据固件版本配置相应网段,如果不知道固件版本,先配置成192段,尝试长ping。不通再配置为169段。联想改IP换logo,还是很拿手的![/scode]

对于固件版本11.50和更早版本:

控制器1(端口1):IP地址:192.168.128.101

控制器1(端口2):IP地址:192.168.129.101

控制器2(端口1):IP地址:192.168.128.102

控制器2(端口2):IP地址:192.168.129.102

对于固件版本11.60及更高版本:

控制器1(端口1):IP地址:169.254.128.101

控制器1(端口2):IP地址:169.254.129.101

控制器2(端口1):IP地址:169.254.128.102

控制器2(端口2):IP地址:169.254.129.102

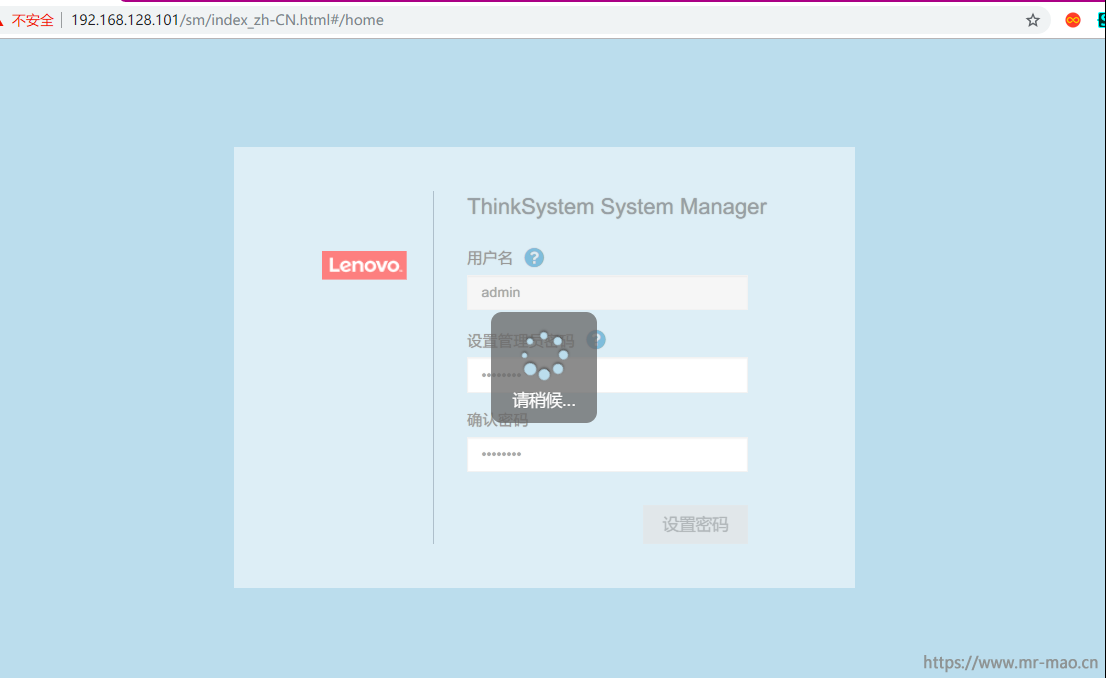

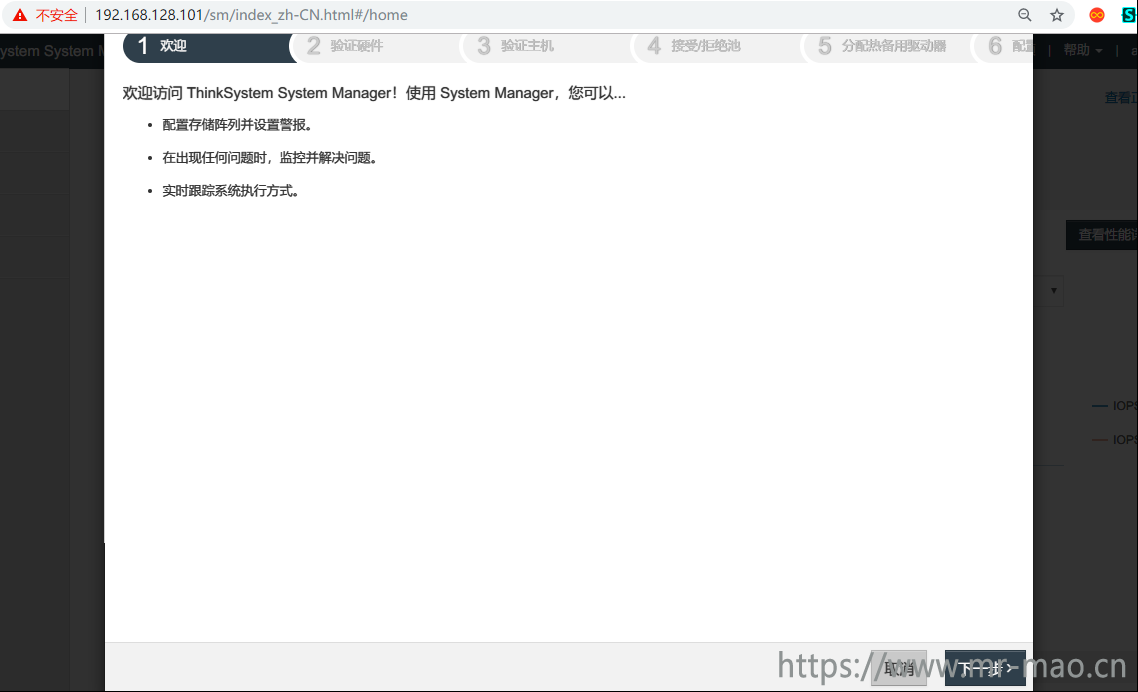

在浏览器中输入:https://192.168.128.101 输入自定义的用户名及密码,然后点击设置密码。

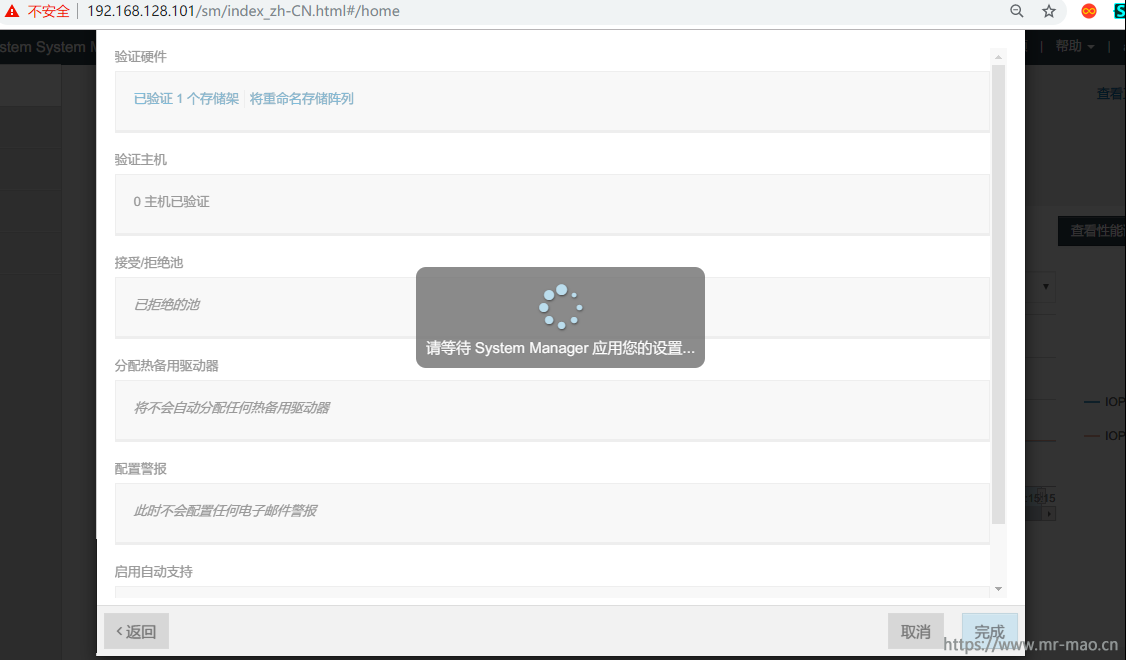

2,填写基本信息

可以后面自行配置池

一直下一步即可

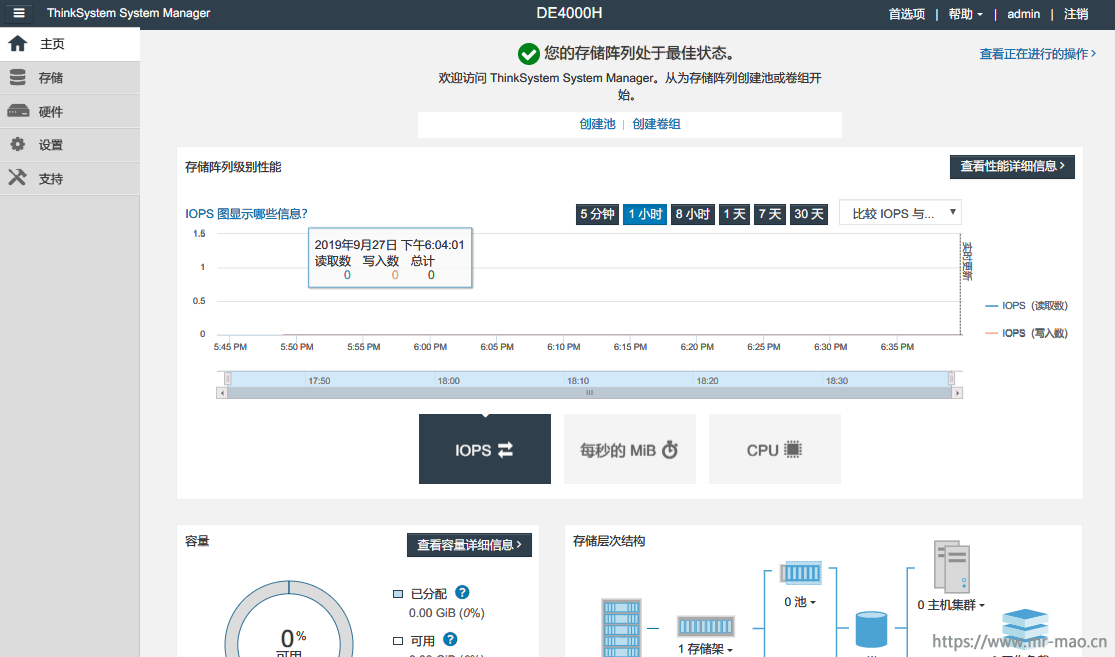

1,配置池或阵列

de系列存储支持Dynamic Disk Pools (DDP)功能,这个功能类似于IBM v系列存储的分布式raid,但是又有区别。

池类似卷组,但具有以下区别:

a,池中的数据随机存储在池中的所有驱动器上,而卷组中的数据则不同,存储在同一组驱动器上。

b,如果驱动器出现故障,池的性能降级程度更低,重建时间更短。

c,池有内置保留容量,因此不需要专用热备用驱动器。

d,池允许将大量驱动器组合到一起。

e,池不需要指定的 RAID 级别。

f,池最少需要11块硬盘,最大可以192。

g,池的磁盘利用率比卷组低,磁盘利用率70%

A,选择创建池。填写池的名称,池的选项已经根据配置自动列出可配置选项,直接选择即可,根据需求选择相应数量磁盘的池,为了演示后续操作,我这里选择13个磁盘的池,点击创建

点击左边菜单栏的存储-池和卷组,13个驱动器的池已经建好

在此界面中看到有一个保留容量的标签,保留容量是为帮助解决潜在的驱动器故障而在池中保留的容量(驱动器数量)。创建池时, System Manager 将自动保留缺省的保留容量,具体容量取决于池中的驱动器数。如果已使用所有可用容量创建卷,则可能无法增加保留容量,除非通过添加驱动器或删除卷来向池中添加容量。

如果觉得池的磁盘利用率比较低,可以选择卷组

B,选择创建卷组。填写名称,选择RAID级别,卷组的选项也根据存储的配置列出一些可选的选项,根据需求自行选择,为了演示后续操作,我这里选择15个磁盘的卷组,点击创建

点击左边菜单栏的存储-池和卷组,15个驱动器的卷组已经建好

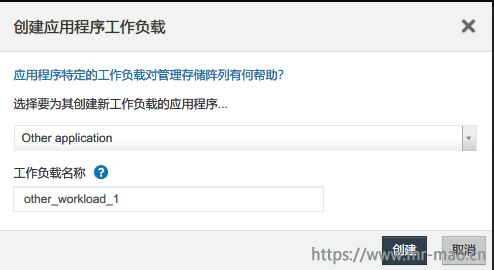

2,创建工作负载

工作负载是支持应用程序的存储对象。可为每个应用程序定义一个或多个工作负载或实例。对于某些应用程序, System Manager 将工作负载配置为采用具有类似基础卷特征的卷。这些卷特征根据工作负载支持的应用程序类型进行优化。应用程序特定的工作负载的卷特性指示工作负载如何与存储阵列的组件交互,有助于确定给定配置下环境的表现。例如,如果创建支持 Microsoft SQL Server 应用程序的工作负载,然后为该工作负载创建卷,则会优化基础卷特征以支持 Microsoft SQL Server。

点击左侧菜单栏的存储-卷,单击创建,选择工作负载,工作负载中自带很多模板,根据需求选择相应的模板即可,如果没有找到,选择Other application,填写名称,单击创建

3,创建卷

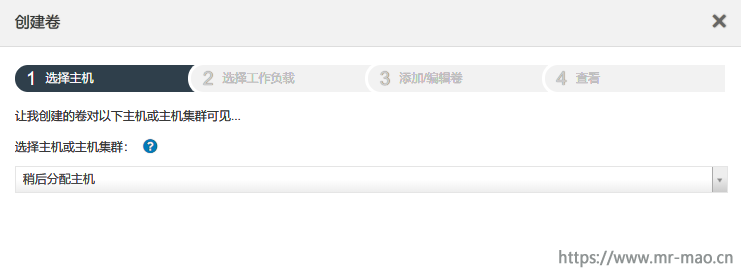

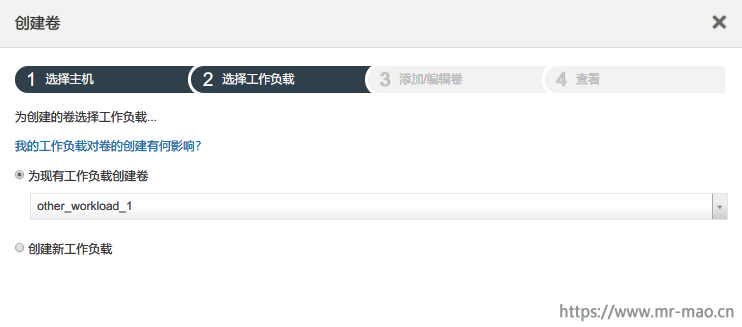

点击左侧菜单栏的存储-卷,单击创建,选择卷,稍后分配主机

点击下一步,选择之前创建好的工作负载

点击下一步,单击添加新卷

填写卷名称,卷容量,根据需求选择段大小,单击下一步,点击完成

4,新建主机

de系列存储的基本端口默认为fc模式,如果插了fc模块,则直接可以识别hba卡,如果需要iSCSI,则需要转换端口协议,转换步骤看后面的教程。

点击左侧菜单栏的存储-主机,单击创建,选择主机。填写主机名称,选择相应的主机操作系统类型,添加主机端口wwpn,这里是fc连接,会自动弹出hba卡的wwpn,单击创建

在新的版本微码中,还需要选择主机接口类型,才能填写主机端口

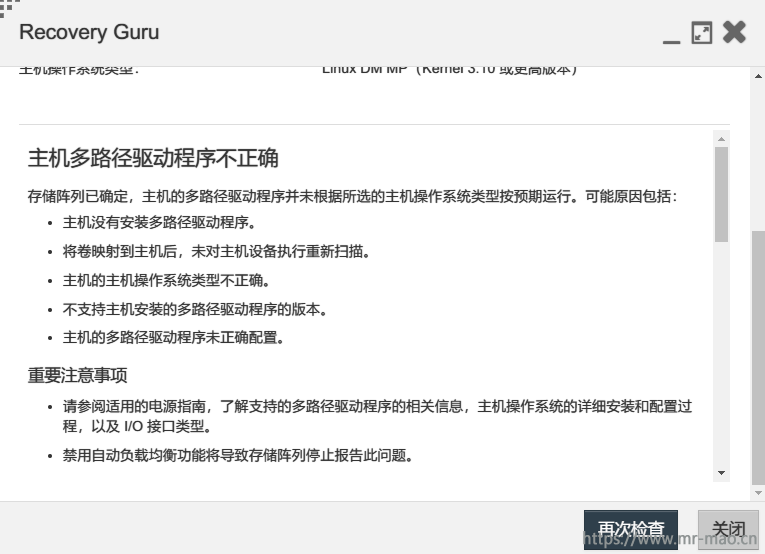

如果主机操作系统类型不正确,或者多路径配置不合适,会报如下错误

5,映射卷

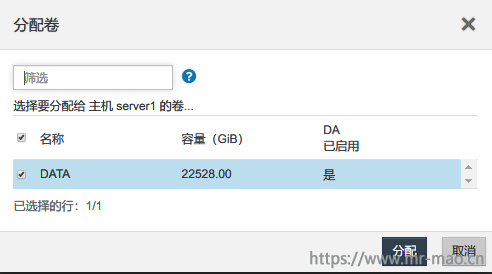

接上一步,选中新建的主机,点击分配卷,选中已经建立的卷,点击分配

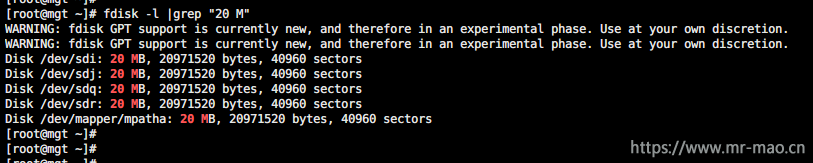

在主机端扫描磁盘,会发现多出几个20M的卷,这是de系列为了实现带内管理自动分配给主机的,即便不映射主机,也会有这个20m分区,如果不需要带内管理,可以取消。

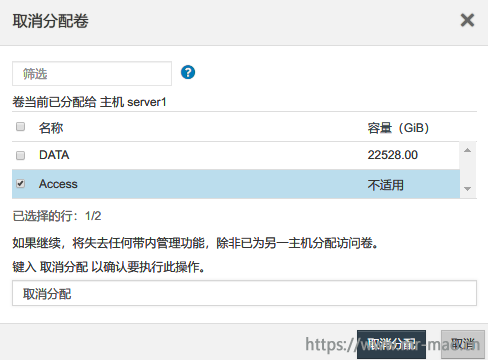

选中创建的主机,点击取消分配卷,弹出对话框中提示:如果继续,将失去任何带内管理功能,除非已为另一主机分配访问卷。选中Access 卷,输入取消分配,点击取消分配

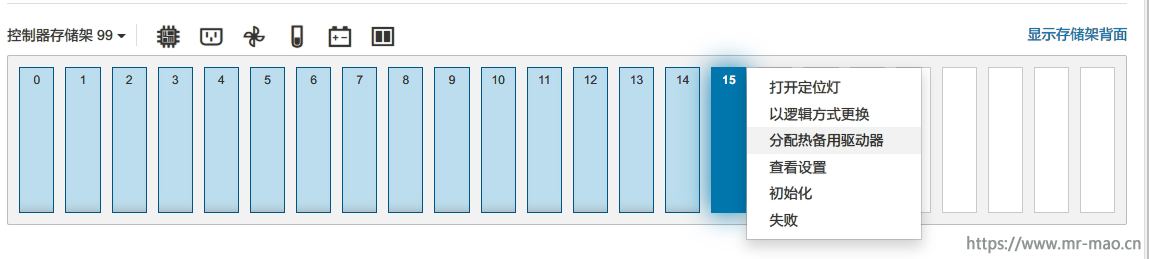

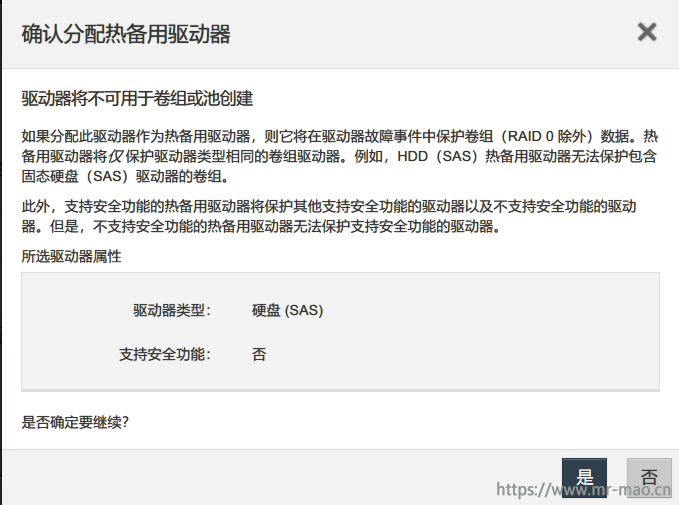

1,配置热备盘

点击左侧菜单栏的硬件,显示存储架正面磁盘示图,阵列成员盘,以浅蓝色显示,未使用磁盘以灰色显示,单击灰色的硬盘,选中分配热备用驱动器

选择 是

2,扩容

a,扩容池或卷组

点击左侧菜单栏的存储-池和卷组,选中现有池或者卷组,单击添加容量,选择没有使用的磁盘,点击添加,扩容卷组的时候,一次最多可以选择2块硬盘

13个磁盘的池,此时扩容成16个磁盘

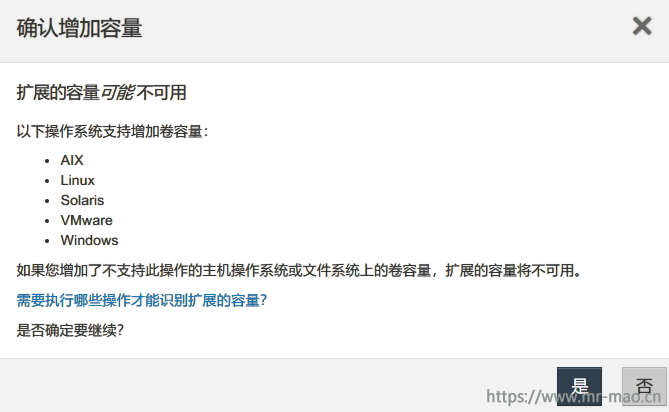

b,扩容卷

点击左侧菜单栏的存储-卷,选中现有卷,单击增加容量,选择是

输入要增加的容量,点击增加

c,在主机端扩容即可,Linux下只有lvm支持扩容

3,更改管理地址

点击左侧菜单栏的硬件,点击显示存储架背面,单击控制器A,点击配置管理端口

选择端口P1,下一步,继续下一步,输入IP地址信息,下一步,直至完成

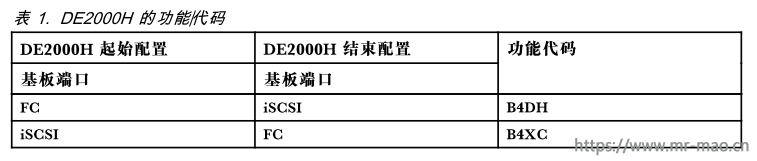

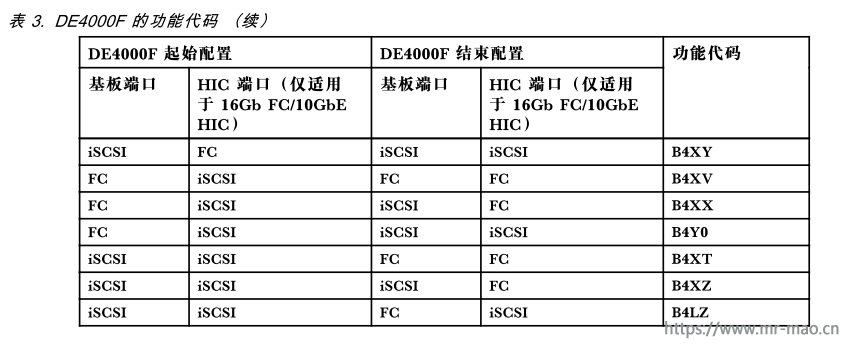

4,更改存储主机接口协议

de系列支持以下型号列出端口更改协议,HIC 端口协议设置仅适用于16Gb FC/10GbE HIC(选件部件号:4C57A14366)

根据上表确定要更改的端口

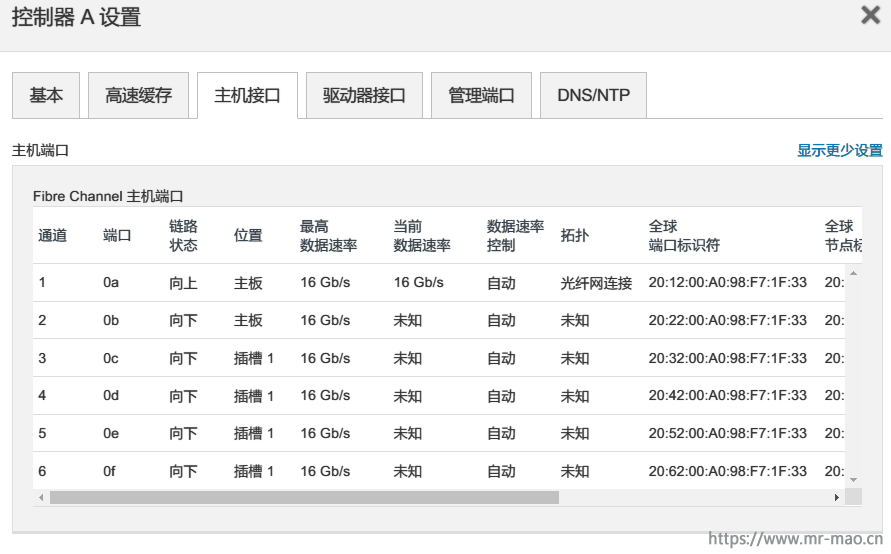

此处我以更改HIC端口为例,在更改之前全部都是fc模式

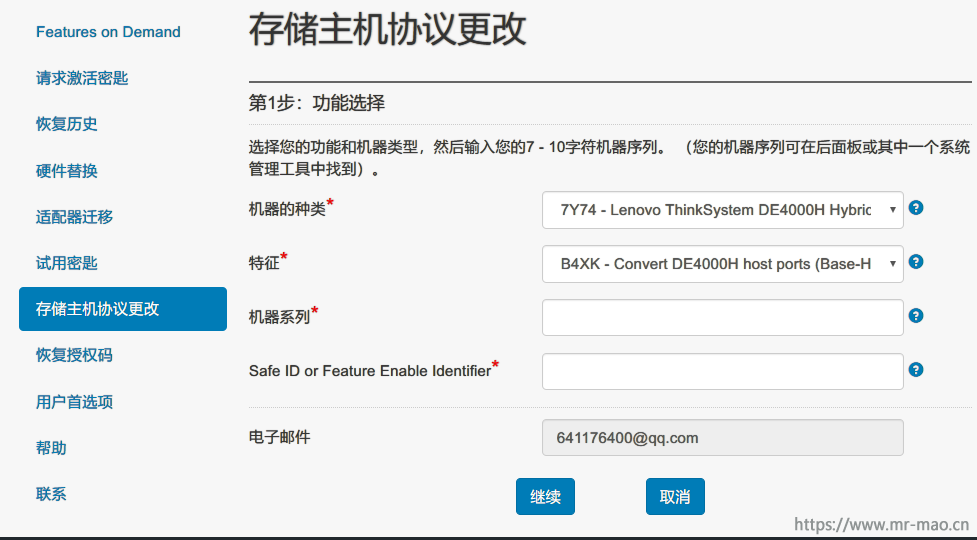

点击存储管理界面的设置-系统,下拉至加载项,在更改功能包菜单下,复制功能启用标识代码

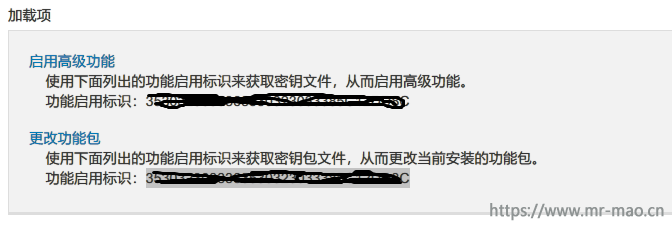

点击存储主机协议更改,选择存储机型,选择要转换的功能特征,填入机器序列号,在Safe ID or Feature Enable Identifier中粘贴上一步复制的功能启用标识,单击继续,直至提示许可申请成功,在邮件的附件中把许可下载到本地

返回至管理界面,点击更改功能包菜单,单击浏览,选择下载的许可文件,输入更改,单击更改,更改之后会重启,等待即可。

重新连接以后,端口协议更改完成,HIC端口变成10gbiSCSI模式

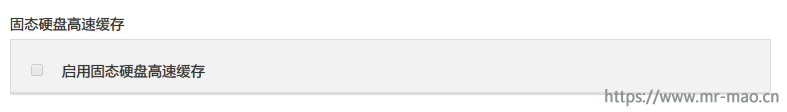

5,SSD读缓存配置

由于我配置的这台存储没有ssd,这里我截图说下步骤

a,创建hdd容量层的池或者卷组,然后创建卷

b,创建SSD卷组

c,选中需要加速读缓存的卷,点击查看/编辑设置,单击高级标签,拉至最下,勾选启用固态硬盘高速缓存

配置以后,点击SSD磁盘组,会显示已经关联的用来加速的卷

6,升级微码

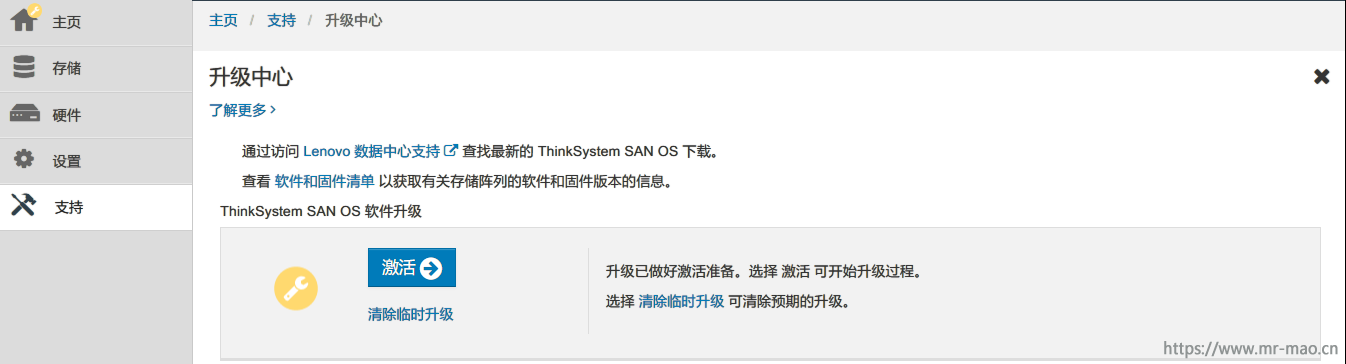

先下载对应的控制器微码和驱动器微码,点击管理界面左侧菜单支持-升级中心,先升级ThinkSystem SAN OS 软件,点击开始升级,弹出的界面中,选择下载好的ThinkSystem SAN OS 软件文件和控制器 NVSRAM 文件,并勾选现在传输文件,但不升级(稍后激活升级),点击开始

弹出确认对话框

进行升级前的健康检测

开始升级

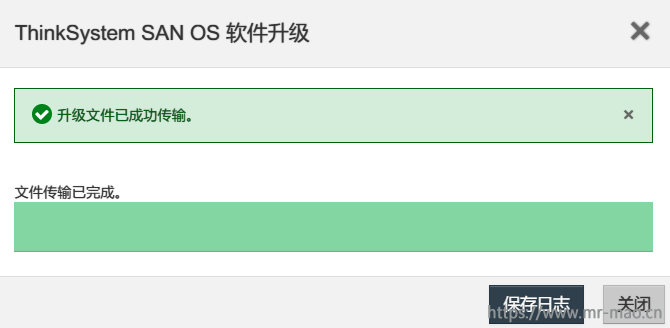

传输完成

确认传输无误,点击激活

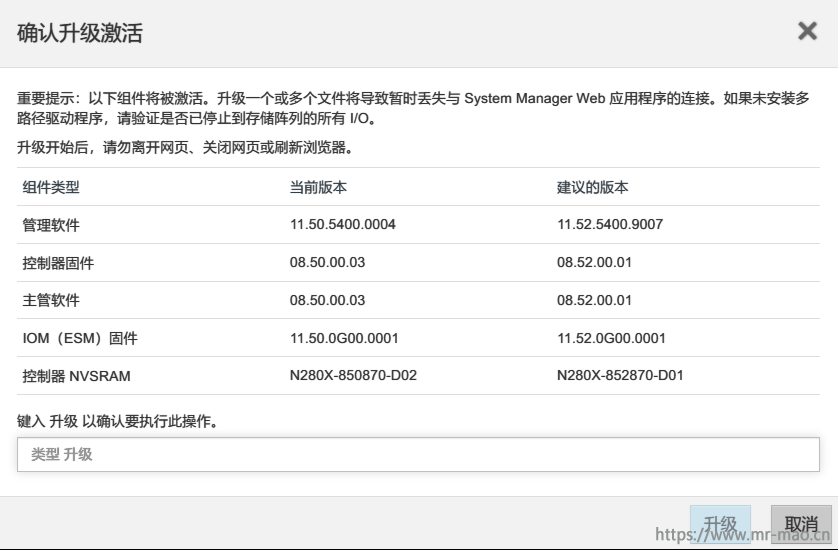

确认激活

升级成功

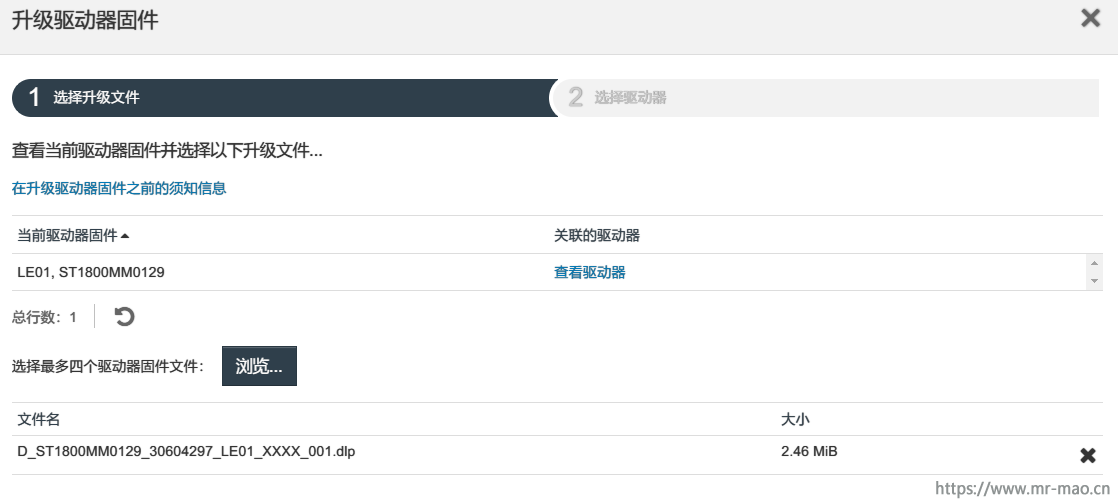

升级驱动器微码,在升级中心中点击开始升级,升级驱动器固件微码。弹出对话框,选择下载好的驱动器微码,点击下一步

出现两种升级选择,联机和脱机

联机

如果池或卷组支持冗余,并且状态为“最佳”,则可使用联机方法升级驱动器固件。联机方法将存储阵列处理 I/O 期间 将固件下载到使用这些驱动器的关联卷。无需停止对使用这些驱动器的关联卷的 I/O。将把这些驱动器一次一个升级到与驱动器关联的卷。如果未将驱动器分配给池或卷组,则可通过联机或脱机方法更新其固件。使用联机方法升级驱动器固件时,系统性能可能会受到影响。

脱机

如果池或卷组不支持冗余(RAID 0),或者已降级,则必须使用脱机方法升级驱动器固件。仅当已停止 I/O 活动时,脱机方法才会将固件升级到使用这些驱动器的关联卷。必须停止对使用这些驱动器的关联卷的所有 I/O。如果未将驱动器分配给池或卷组,则可通过联机或脱机方法更新其固件。

根据存储环境选择相应的升级方案,因为我当前存储的硬盘微码已经是最新了,所以就没法升级了。

附Linux下多路径配置参数

devices{

device {

vendor "LENOVO"

product "DE_Series"

product_blacklist "Universal Xport"

path_grouping_policy group_by_prio

features "2 pg_init_retries 50"

path_checker rdac

path_selector "round-robin 0"

hardware_handler "1 rdac"

prio rdac

failback immediate

rr_weight priorities

no_path_retry 30

}

}